Sådan indsamler du 100+ relaterede spørgsmål til dine målnøgleord

Sidst opdateret den lørdag den 11. november 2023

Så hvordan kan dit website få en plads i de enorme resultater, nettet giver? Svarene ligger måske i spørgsmålene!

I dagens artikel vil vi bygge en "People Also Ask"-scraper til at indsamle hundredvis (eller endda tusindvis) af relaterede spørgsmål omkring dine målsøgeord, så du kan opbygge en mere omfattende emneklynge, optimere dit indhold og forbedre søgeintentionen.

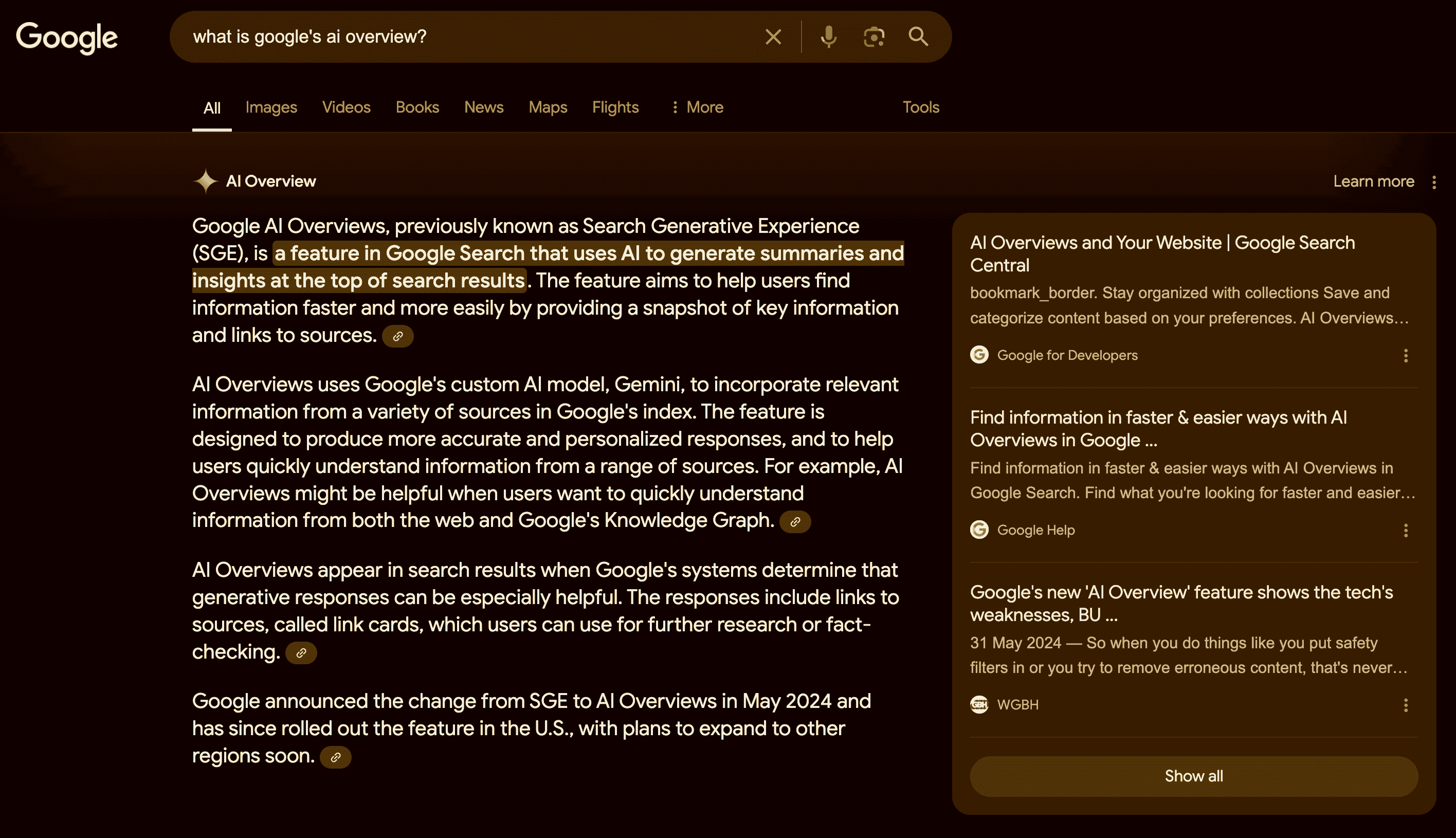

Hvad er "Folk spørger også"?

Googles "People Also Ask"-funktion er en del af søgeresultaterne, der viser relaterede spørgsmål og svar fra andre kilder. Det hjælper brugerne med at finde flere oplysninger om deres forespørgsel eller udforske forskellige aspekter af emnet.

Funktionen er dynamisk og kan udvides eller ændres afhængigt af brugerens interaktion.

Sådan bruger du PAA-spørgsmål til at booste din SEO

Selvom "People Also Ask" (PAA) primært er en slutbrugerfunktion, kan den være en god allieret, når du skal skabe og optimere dit websteds indhold.

Ideen bag PAA er at hjælpe brugere med at finde yderligere oplysninger om deres forespørgsel eller hjælpe fortabte brugere, der ikke er sikre på, hvordan de skal søge efter et stykke information, så Google er nødt til at "forudsige" hensigten bag søgningen.

Forstår du ideen nu?

PAA-spørgsmål er en god måde at identificere potentielle spørgsmål, som dit indhold bør besvare - hvilket øger emnets autoritet - eller nye emner til at skabe indhold omkring dit hovednøgleord.

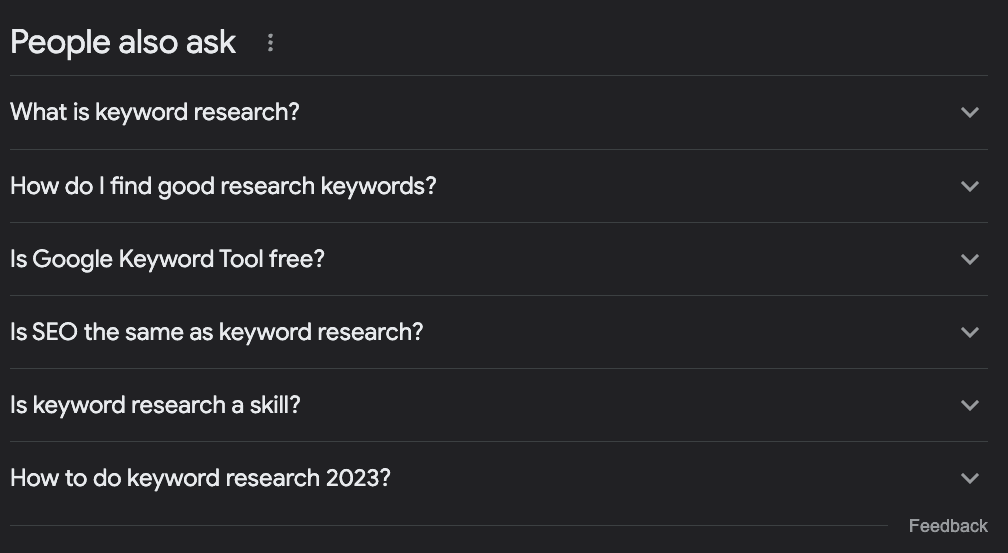

Lad os f.eks. sige, at du vil skrive en artikel om søgeordsanalyse. Hvad skal du så skrive om?

De fleste mennesker vil søge efter måltermen i Google, se på, hvad der allerede rangerer, og kalde det en dag.

Men hvis vi tjekker PAA-boksen, finder vi nogle interessante ideer:

Hvad er søgeordsforskning?

Hvordan finder jeg gode research-søgeord?

Er Google Keyword Tool gratis?

Er SEO det samme som søgeordsanalyse?

Hvordan laver man søgeordsanalyse i 2023?

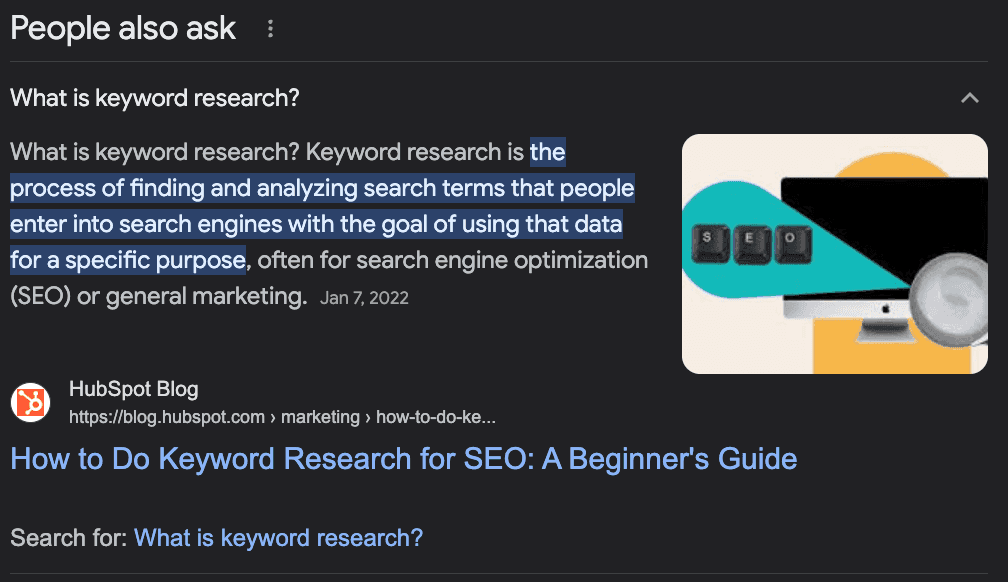

Alene ud fra disse spørgsmål kan vi afgøre et par ting:

Spørgsmålet "Er SEO det samme som søgeordsresearch?" fortæller os, at det er et emne på et meget lavt niveau, så folk, der søger på dette udtryk, er begyndere, og vi bør sætte tonen for dem.

Det er et emne i udvikling, som skal opdateres ofte, da vi har et spørgsmål om det aktuelle år.

Vi bør tilføje et afsnit med overskrifterne "Hvad er søgeordsforskning?" og "Hvordan finder jeg gode søgeord" - jeg ville ikke bruge den anden præcis sådan, men du forstår pointen.

Vi bør nævne, hvordan man bruger "Google Keyword Planner" som en del af vejledningen, da Google knytter det til forespørgslen.

Vi kan få en masse værdifulde oplysninger om vores søgeord, opbygge en liste over relaterede søgeord, optimere vores indhold til at besvare almindelige spørgsmål omkring målsøgeordet og finde nye emneideer til at opbygge komplette emneklynger.

Indsamling af "folk spørger også"-spørgsmål med Python

Der er dog en udfordring. At indsamle alle disse spørgsmål til vores eksisterende indhold eller som støtte til planlægning af vores indhold er en tidskrævende og ressourcekrævende opgave.

SEO'er og indholdsansvarlige har allerede en masse arbejde med at tilføje ekstra research, så hvordan løser vi det?

Enkelt, vi automatiserer processen!

Vi bygger en webscraper, der:

Tager en liste med søgeord

Navigerer til søgeordets SERP

Udtrækker alle PAA-spørgsmål

Eksporterer oplysningerne til en CSV

I denne vejledning bruger vi Python med et simpelt værktøj til at tage sig af al kompleksiteten, og du vil kunne bruge den resulterende kode ved blot at ændre nøgleordene.

Er du klar? Lad os komme i gang.

Trin 1: Opsætning af dit projekt

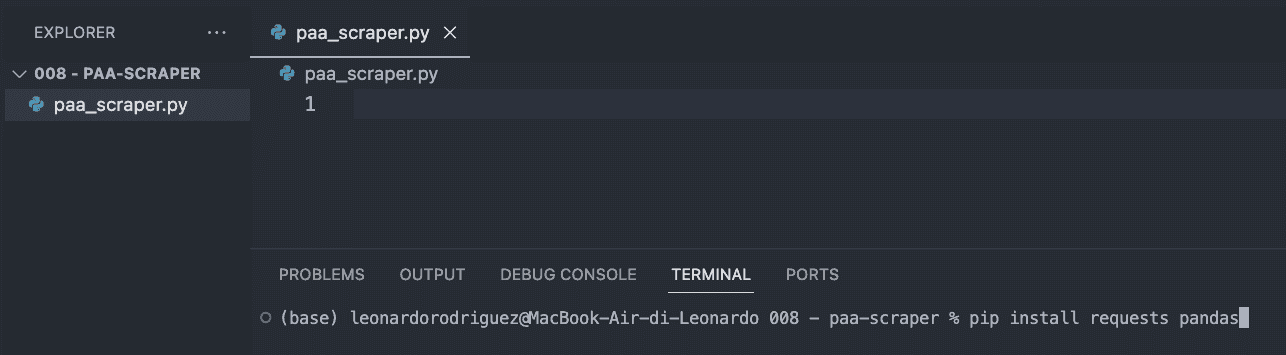

Det første, du skal gøre, er at oprette en ny mappe til dit projekt (kald den paa-scraper) og oprette en ny paa_scraper.py-fil indeni.

Hvis du bruger Mac, har din maskine allerede en version af Python installeret. Hvis du bruger Windows, skal du følge denne vejledning for at få det på din maskine.

Åbn derefter mappen i VScode og en ny terminal.

Derfra skal du indtaste følgende kommando.

pip install anmodninger pandasKommandoen ovenfor vil installere to nyttige værktøjer (afhængigheder):

Requests giver os mulighed for at bede om de oplysninger, vi ønsker at udtrække

Pandas hjælper os med at eksportere oplysningerne som en CSV-fil

For at afslutte dette trin skal du importere begge afhængigheder øverst i filen.

import requests import pandas as pdTrin 2: Sende vores anmodning gennem ScraperAPI

For at få de data, vi leder efter, skal vi traditionelt bygge en scraper, der navigerer til Google, søger efter oplysningerne ved hjælp af CSS-selektorer, vælger oplysningerne, formaterer dem ... du ved, hvad jeg mener? Det er normalt en masse logik.

I stedet kan vi bruge et webscraping-værktøj til at reducere omkostninger, implementeringstid og vedligeholdelse.

Ved at sende vores anmodning gennem ScraperAPI's strukturerede dataendpunkter kan vi hente PAA-spørgsmålene fra enhver forespørgsel uden at bekymre os om at analysere HTML, blive blokeret eller andre problemer, vi måtte stå over for.

For at komme i gang skal du oprette en gratis ScraperAPI-konto og gå til dit dashboard for at kopiere din API-nøgle.

Derefter opretter vi en payload på denne måde:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }Landeparameteren fortæller ScraperAPI, hvorfra den skal sende dine anmodninger - husk, at Google viser forskellige resultater baseret på din placering - mens forespørgselsparameteren indeholder dit søgeord.

Når disse parametre er klar, kan vi sende vores anmodning ved hjælp af get()-metoden:

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Trin 3: Udskrivning af PAA-spørgsmål

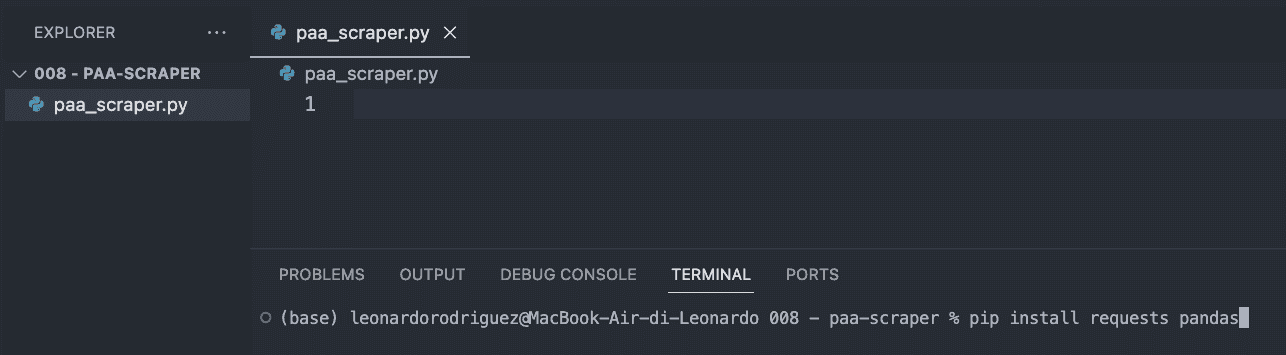

Hvis vi udskriver(response.text), får vi denne information:

Som du kan se, returnerer værktøjet hele SERP'en som JSON-data, og de vigtigste spørgsmål, der er relateret til forespørgslen, findes i nøglen "related_questions".

Fordi vi får strukturerede data i stedet for rå HTML-data, kan vi vælge specifikke elementer ved hjælp af deres nøglenavn:

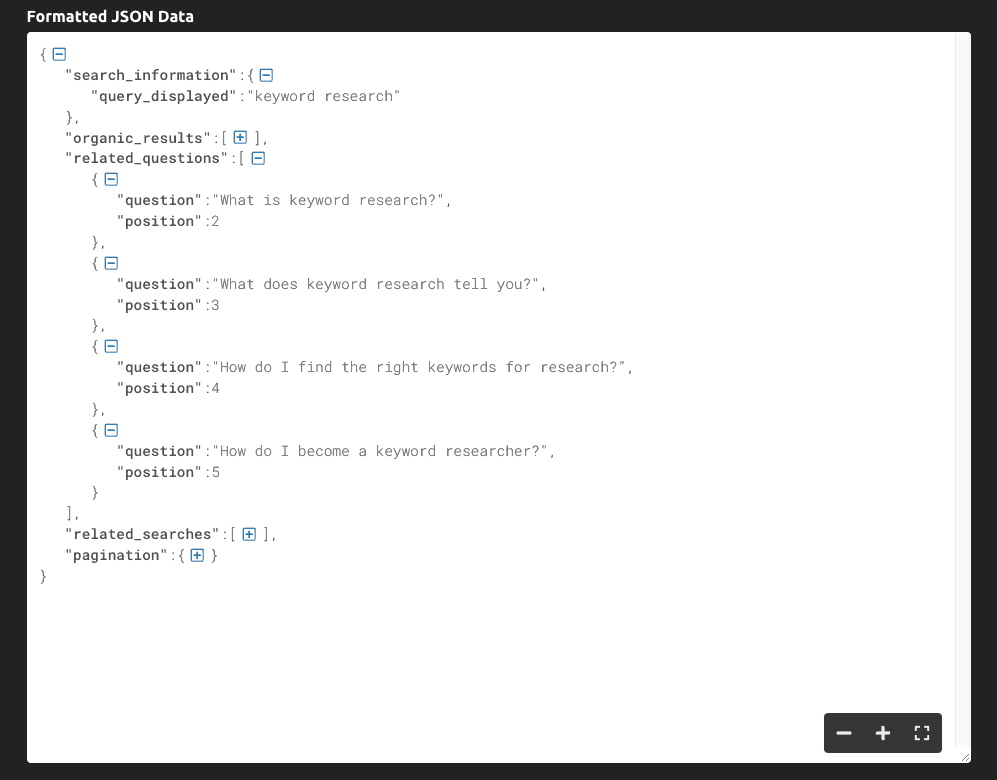

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])Vi gemmer hele JSON-svaret i en serp-variabel

Vi tager fat i "related_questions" og opretter en liste over elementer - hvor hvert element er et PAA-spørgsmål

For at få fat i spørgsmålene looper vi gennem listen og udskriver kun "question"-nøglen

Resultatet af dette er en liste over PAA-spørgsmål, der udskrives på konsollen:

Trin 4: Eksport af data til en CSV-fil

Til CSV-filen vil vi måske også gerne matche søgeordet med PAA-spørgsmålet, så lad os få fat i det:

keyword = serp['search_information']['query_displayed']Når dette er gjort, opretter vi en tom liste, som vi bruger til at formatere dataene, som vi vil:

paa_questions = []Og tilføjer de udtrukne oplysninger til den:

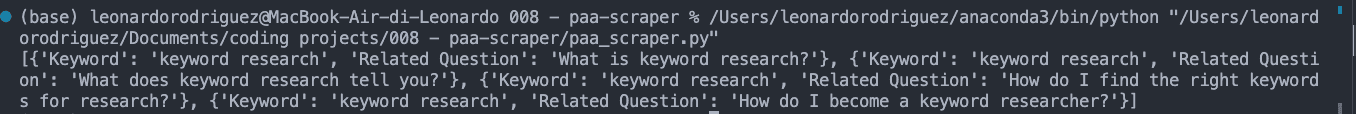

for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] })Hvis vi udskriver paa_questions, ser det sådan ud i konsollen:

Dette er vigtigt, fordi det er basen for CSV-filen og vil hjælpe os med at identificere, hvor spørgsmålet kommer fra, når vi udvider scraperen til tusindvis af søgeord.

I det sidste trin opretter vi CSV-filen ved hjælp af Pandas, så den er nem at eksportere:

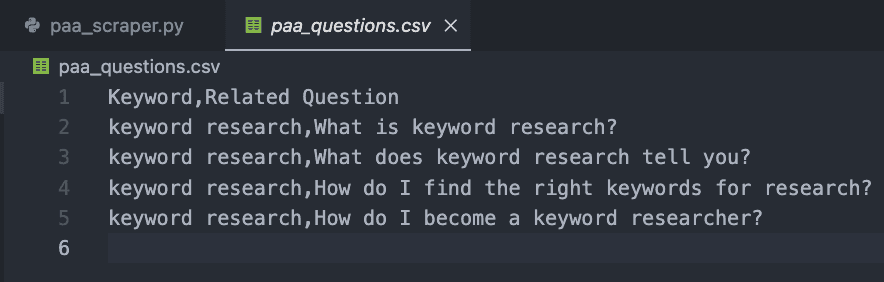

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Hvis du kører din kode nu, vil den ikke udskrive noget til konsollen. I stedet vil den oprette en ny CSV-fil som denne:

Trin 5: Indsamling af PAA-spørgsmål i stor skala

Det kan selvfølgelig gøres i hånden at få spørgsmålene til bare ét nøgleord, så hvordan skalerer vi dette projekt?

Det er det smukke ved webscraping. Det hele handler om loopet!

Opret først en liste med dine ønskede søgeord:

keywords = { 'keyword+research', 'keyword+tracker' }Derefter sætter vi al vores tidligere kode ind i et nyt loop, som tager hver term på søgeordslisten og kører hele processen.

Her er det endelige og fulde kodestykke:

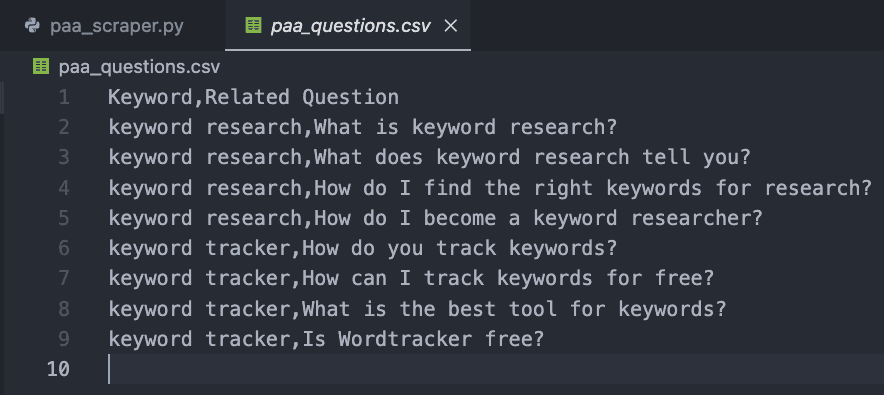

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Til testformål tilføjede vi kun to, men du kan oprette en liste med tusindvis eller endda millioner af målrettede søgeord.

Resultatet er en letlæselig CSV-fil:

Tillykke, du har lige indsamlet dine første 9 PAA-spørgsmål! 🎉

Indpakning

I denne artikel har du lært, hvordan du gør:

Starte en ny Python-scraper

Sende HTTP-anmodninger gennem ScraperAPI

Vælge specifikke datapunkter

Formaterer de udtrukne data

Eksportere data til en CSV-fil

Du kan gøre koden ovenfor til din egen ved at tilføje din API-nøgle og en liste over søgeord i variablen keywords. Du kan også bruge den samme logik til at indsamle topplaceringer for hvert målnøgleord og skalere din researchindsats ved at automatisere disse processer.

Hvis du ikke ønsker at håndtere kodning, kan du også bruge ScraperAPI's DataPipeline, et værktøj uden kode, der er designet til at automatisere hele scraping-projekter uden at skrive en eneste linje kode. Du skal bare tilføje din liste med søgeord og lade værktøjet gøre resten.

Indsamling og brug af PAA-spørgsmål til at forbedre dit websteds indhold er et hemmeligt våben, som de fleste SEO-professionelle ignorerer. Data er din bedste ven, hvis du ved, hvordan du skal bruge dem, så vær kreativ og skub til grænserne for at dominere din niche!

Har du brug for en måde at spore din SEO-indsats på? Start din gratis prøveperiode på Accuranker, og få det fulde billede af din SEO-kampagne med et par klik.

Artikel af:

Leonardo

Ledende teknisk skribent hos ScraperAPI

Leo er en teknisk indholdsforfatter baseret i Italien med erfaring i Python og Node.js. Han arbejder i øjeblikket for ScraperAPI som ledende teknisk skribent og content manager....