So sammeln Sie 100+ verwandte Fragen zu Ihren Zielkeywords

Zuletzt aktualisiert am Samstag, 11. November 2023

Wie kann sich Ihre Website also einen Platz in den umfangreichen Ergebnissen des Internets sichern? Nun, die Antworten liegen vielleicht in den Fragen!

Im heutigen Artikel werden wir einen "People Also Ask"-Scraper erstellen, um Hunderte (oder sogar Tausende) von verwandten Fragen zu Ihren Ziel-Keywords zu sammeln. So können Sie ein umfassenderes Themencluster erstellen, Ihre Inhalte optimieren und die Suchabsicht verbessern.

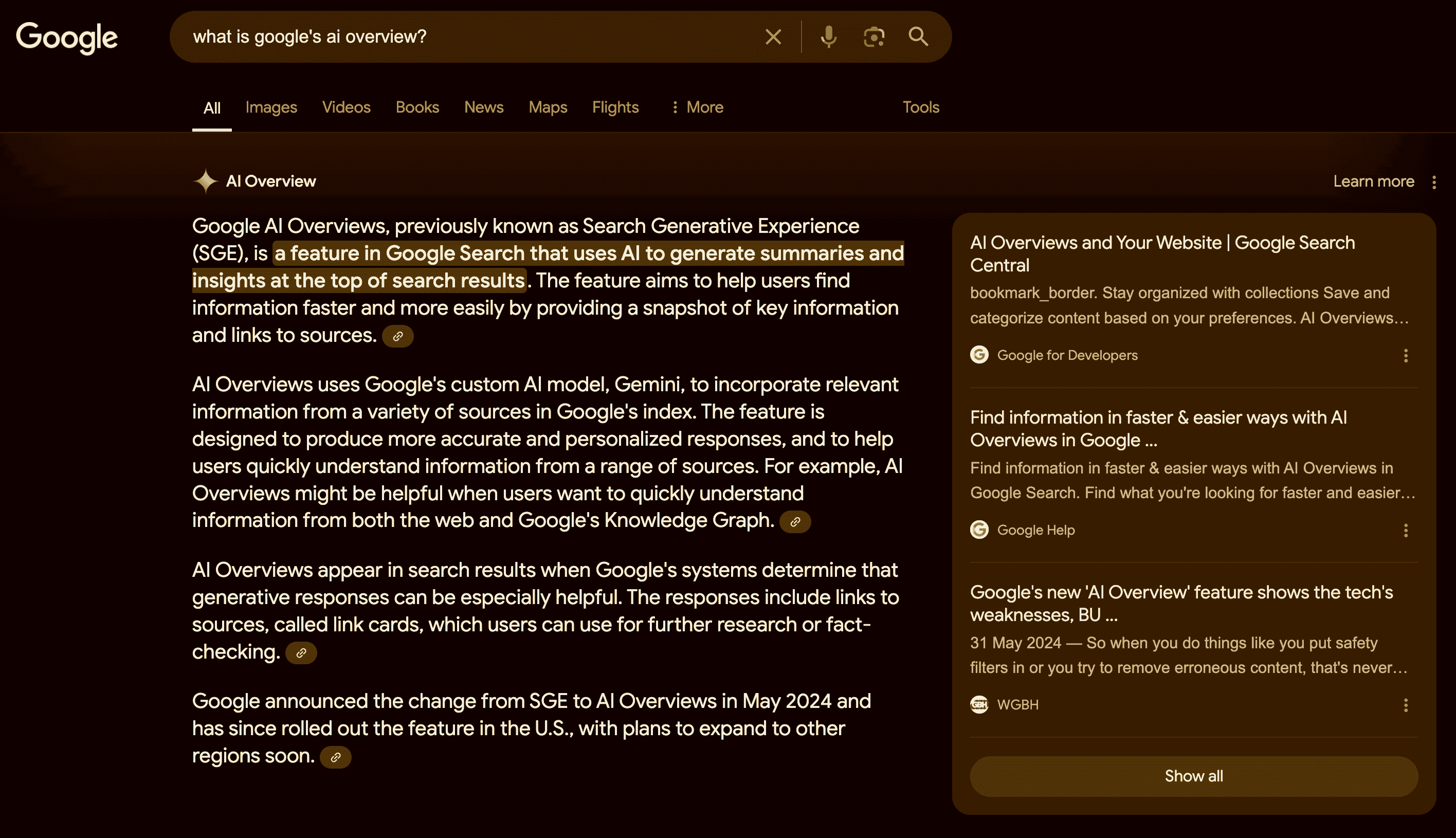

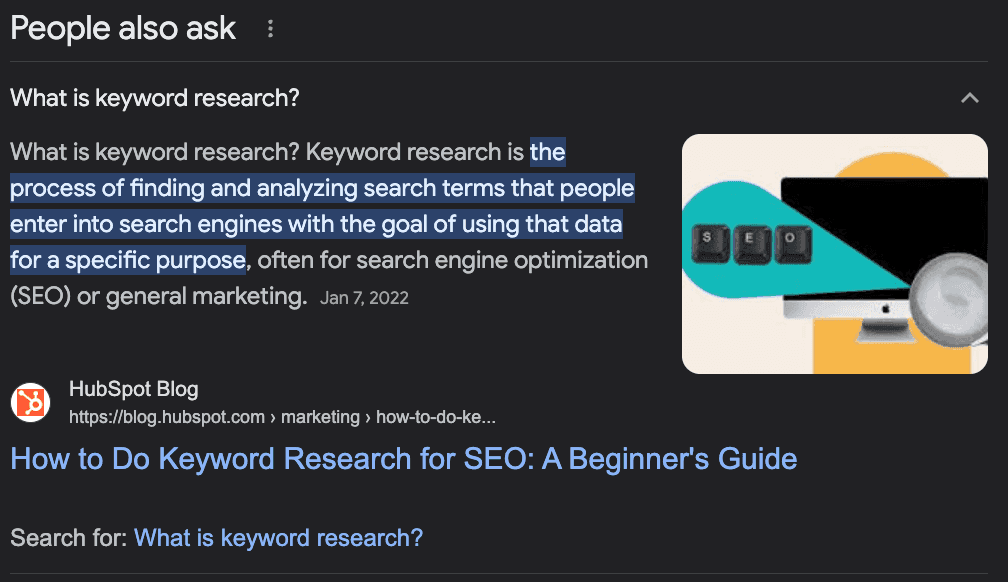

Was ist "Leute fragen auch"?

Die Funktion "Andere fragen auch" von Google ist ein Abschnitt der Suchergebnisse, der verwandte Fragen und Antworten aus anderen Quellen anzeigt. Sie hilft Nutzern, weitere Informationen zu ihrer Anfrage zu finden oder verschiedene Aspekte des Themas zu erkunden.

Die Funktion ist dynamisch und kann je nach Interaktion des Nutzers erweitert oder verändert werden.

Wie Sie PAA-Fragen nutzen, um Ihre SEO zu verbessern

Obwohl es sich bei "People Also Ask" (PAA) hauptsächlich um eine Funktion für Endbenutzer handelt, kann sie bei der Erstellung und Optimierung des Inhalts Ihrer Website ein großer Verbündeter sein.

Die Idee hinter PAA ist es, Nutzern dabei zu helfen, zusätzliche Informationen zu ihrer Anfrage zu finden oder verirrten Nutzern zu helfen, die sich nicht sicher sind, wie sie nach einer bestimmten Information suchen sollen, so dass Google die Absicht hinter der Suche "vorhersagen" muss.

Verstehen Sie jetzt die Idee?

PAA-Fragen sind eine gute Möglichkeit, potenzielle Fragen zu identifizieren, die Ihr Inhalt beantworten sollte - und damit die Themenautorität zu erhöhen - oder neue Themen zu finden, um Inhalte rund um Ihr Hauptkeyword zu erstellen.

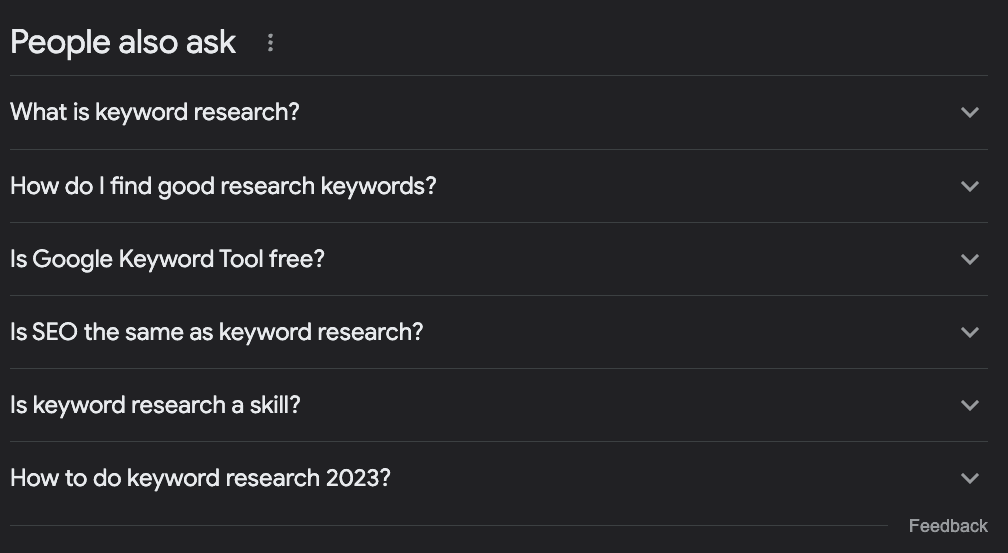

Nehmen wir zum Beispiel an, Sie möchten einen Artikel über die Keyword-Recherche schreiben. Was sollten Sie behandeln?

Die meisten Leute werden nach dem Zielbegriff in Google suchen, sich ansehen, was bereits in den Rankings steht, und es dann dabei belassen.

Wenn wir jedoch die PAA-Box überprüfen, finden wir einige interessante Ideen:

Was ist Keyword-Recherche?

Wie finde ich gute Suchbegriffe?

Ist das Google Keyword Tool kostenlos?

Ist SEO dasselbe wie Keyword-Recherche?

Wie macht man Keyword-Recherche 2023?

Allein aus diesen Fragen können wir einige Dinge ableiten:

Die Frage "Ist SEO dasselbe wie Keyword-Recherche?" zeigt uns, dass es sich um ein sehr einsteigerfreundliches Thema handelt, d. h. die Leute, die nach diesem Begriff suchen, sind Anfänger, und wir sollten für sie den Ton angeben.

Es handelt sich um ein sich entwickelndes Thema, das häufig aktualisiert werden muss, da wir eine Frage zum aktuellen Jahr haben.

Wir sollten einen Abschnitt mit den Überschriften "Was ist Keyword-Recherche?" und "Wie finde ich gute Suchbegriffe" hinzufügen - den zweiten würde ich nicht genau so verwenden, aber Sie verstehen, worum es geht.

Wir sollten erwähnen, wie man den "Google Keyword Planner" als Teil des Tutorials verwendet, da Google ihn mit der Suchanfrage verknüpft.

Wir können viele wertvolle Informationen über unsere Schlüsselwörter erhalten, eine Liste verwandter Schlüsselwörter erstellen, unsere Inhalte so optimieren, dass sie häufige Fragen rund um das Zielschlüsselwort beantworten, und neue Themenideen finden, um komplette Themencluster zu erstellen.

Sammeln von "People Also Ask"-Fragen mit Python

Es gibt jedoch eine Herausforderung. Das Sammeln all dieser Fragen für unsere bestehenden Inhalte oder zur Unterstützung bei der Planung unserer Inhalte ist eine zeit- und ressourcenaufwändige Aufgabe.

SEOs und Content-Manager haben bereits eine Menge Arbeit, um zusätzliche Recherchen durchzuführen. Wie lösen wir das Problem?

Ganz einfach, wir automatisieren den Prozess!

Wir bauen einen Web Scraper, der:

Eine Liste von Keywords aufnehmen

zur SERP des Suchbegriffs navigiert

Alle PAA-Fragen extrahieren

die Informationen in eine CSV-Datei exportiert

Für dieses Tutorial verwenden wir Python mit einem einfachen Tool, um die Komplexität zu bewältigen, und Sie können den resultierenden Code verwenden, indem Sie einfach die Schlüsselwörter ändern.

Sind Sie bereit? Dann fangen wir an.

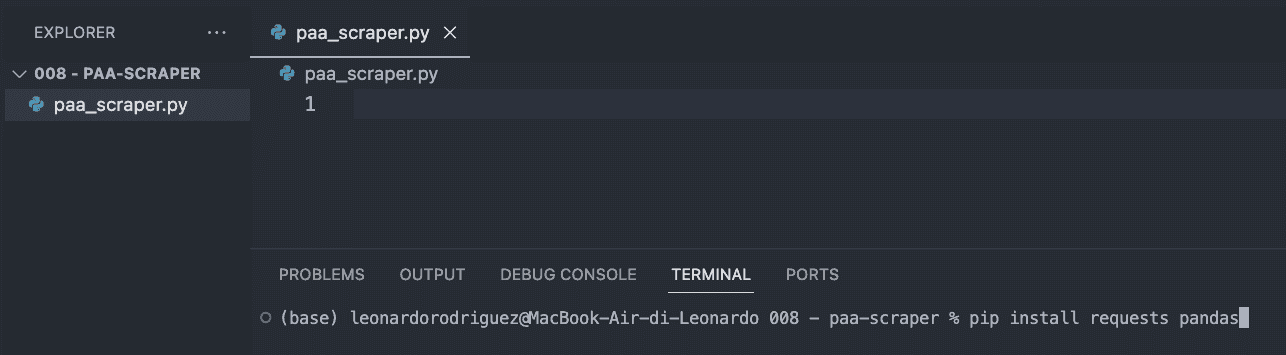

Schritt 1: Einrichten Ihres Projekts

Als erstes müssen Sie einen neuen Ordner für Ihr Projekt erstellen (nennen Sie ihn paa-scraper) und darin eine neue Datei paa_scraper.py erstellen.

Wenn Sie mit einem Mac arbeiten, ist auf Ihrem Rechner bereits eine Version von Python installiert. Wenn Sie mit Windows arbeiten, folgen Sie dieser Anleitung, um es auf Ihrem Rechner zu installieren.

Öffnen Sie nun den Ordner in VScode und ein neues Terminal.

Geben Sie von dort aus den folgenden Befehl ein.

pip install anfragen pandasMit dem obigen Befehl werden zwei nützliche Tools (Abhängigkeiten) installiert:

Mit Requests können wir nach den Informationen fragen, die wir extrahieren möchten.

Pandas hilft uns, die Informationen als CSV-Datei zu exportieren

Um diesen Schritt abzuschließen, importieren Sie beide Abhängigkeiten am Anfang der Datei.

importiere Anfragen importiere Pandas als pdSchritt 2: Senden unserer Anfrage über die ScraperAPI

Um die gesuchten Daten zu erhalten, müssten wir traditionell einen Scraper erstellen, der zu Google navigiert, die Informationen mithilfe von CSS-Selektoren sucht, die Informationen auswählt, sie formatiert... Sie wissen, was ich meine? Das ist normalerweise eine Menge Logik.

Stattdessen können wir ein Web-Scraping-Tool verwenden, um Kosten, Implementierungszeit und Wartungsaufwand zu reduzieren.

Indem wir unsere Anfrage über die strukturierten Datenendpunkte von ScraperAPI senden, können wir die PAA-Fragen einer beliebigen Abfrage abrufen, ohne uns Gedanken über das Parsen des HTML zu machen, blockiert zu werden oder andere Probleme zu haben, denen wir begegnen könnten.

Um loszulegen, erstellen Sie ein kostenloses ScraperAPI-Konto und gehen Sie zu Ihrem Dashboard, um Ihren API-Schlüssel zu kopieren.

Dann erstellen wir eine Nutzlast wie diese:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }Der Länderparameter teilt ScraperAPI mit, von wo aus die Anfragen gesendet werden sollen - denken Sie daran, dass Google je nach Standort unterschiedliche Ergebnisse anzeigt -, während der Abfrageparameter Ihr Schlüsselwort enthält.

Mit diesen Parametern können wir unsere Anfrage mit der get()-Methode senden:

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Schritt 3: Drucken von PAA-Fragen

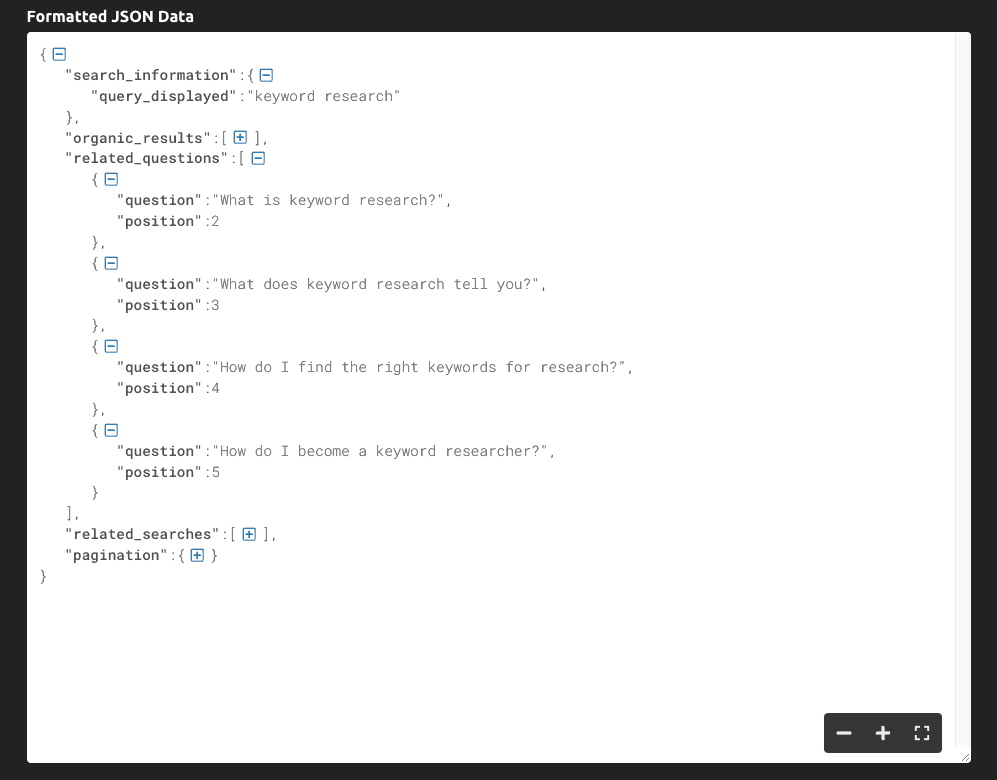

Wenn wir print(response.text) ausgeben, erhalten wir die folgenden Informationen:

Wie Sie sehen können, gibt das Tool die gesamte SERP als JSON-Daten zurück, und die wichtigsten Fragen im Zusammenhang mit der Abfrage befinden sich im Schlüssel "related_questions".

Da wir strukturierte Daten anstelle von HTML-Rohdaten erhalten, können wir bestimmte Elemente anhand ihres Schlüsselnamens auswählen:

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])Wir speichern die gesamte JSON-Antwort in einer serp-Variablen

Wir erfassen die "related_questions" und erstellen eine Liste von Elementen - wobei jedes Element eine PAA-Frage ist

Um die Fragen zu erfassen, durchlaufen wir die Liste in einer Schleife und geben nur den Schlüssel "question" aus.

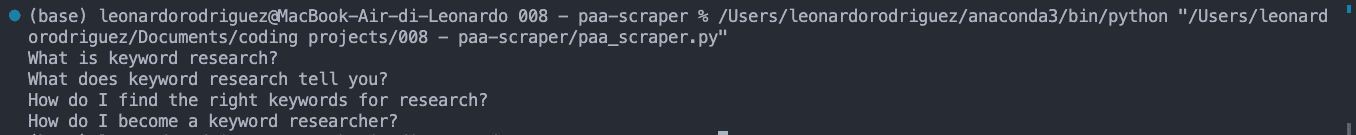

Das Ergebnis ist eine Liste von PAA-Fragen, die auf der Konsole ausgegeben wird:

Schritt 4: Exportieren der Daten in eine CSV-Datei

Für die CSV-Datei möchten wir vielleicht auch das Schlüsselwort mit der PAA-Frage abgleichen, also holen wir es uns:

keyword = serp['search_information']['query_displayed']Danach erstellen wir eine leere Liste, mit der wir die Daten wie gewünscht formatieren können:

paa_questions = []Und fügen die extrahierten Informationen an diese Liste an:

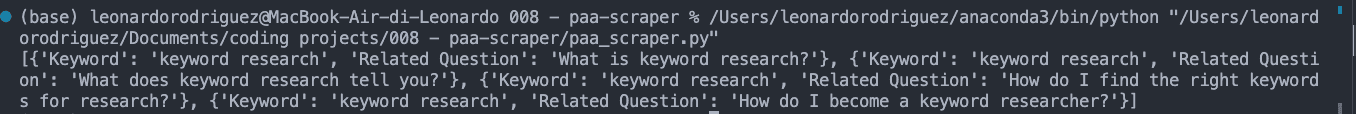

for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] })Wenn wir paa_questions ausdrucken, sieht es in der Konsole folgendermaßen aus:

Dies ist wichtig, weil es die Basis der CSV-Datei ist und uns helfen wird, zu erkennen, woher die Frage kommt, wenn wir den Scraper auf Tausende von Schlüsselwörtern erweitern.

Im letzten Schritt erstellen wir die CSV-Datei mit Pandas, um den Export zu erleichtern:

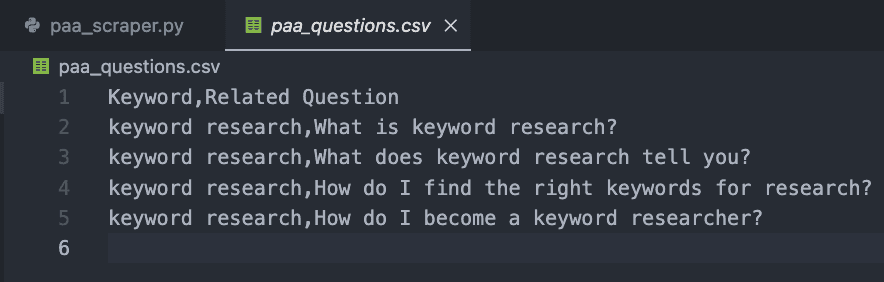

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Wenn Sie Ihren Code jetzt ausführen, wird nichts auf der Konsole ausgegeben. Stattdessen wird eine neue CSV-Datei wie diese erstellt:

Schritt 5: Erfassen von PAA-Fragen im großen Maßstab

Natürlich kann man die Fragen für nur ein Schlüsselwort von Hand erfassen.

Nun, das ist das Schöne am Web Scraping. Es dreht sich alles um die Schleife!

Erstellen Sie zunächst eine Liste mit den gewünschten Schlüsselwörtern:

keywords = { 'keyword+research', 'keyword+tracker' }Dann fügen wir unseren gesamten vorherigen Code in eine neue Schleife ein, die jeden Begriff aus der Liste der Schlüsselwörter aufnimmt und den gesamten Prozess durchläuft.

Hier ist der endgültige und vollständige Codeschnipsel:

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Zu Testzwecken haben wir nur zwei hinzugefügt, aber Sie können eine Liste mit Tausenden oder sogar Millionen von gezielten Schlüsselwörtern erstellen.

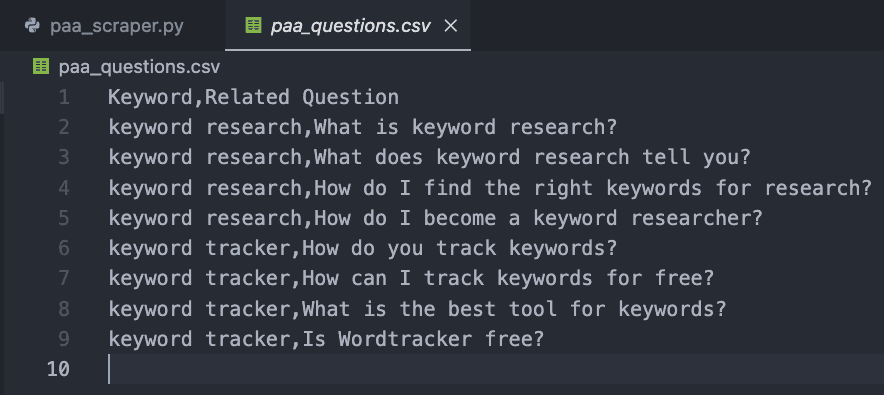

Das Ergebnis ist eine leicht zu lesende CSV-Datei:

Herzlichen Glückwunsch, Sie haben gerade Ihre ersten 9 PAA-Fragen gesammelt! 🎉

Zusammenfassung

In diesem Artikel haben Sie gelernt, wie man:

Einen neuen Python-Scraper starten

HTTP-Anfragen über die ScraperAPI zu senden

Bestimmte Datenpunkte auszuwählen

Formatieren der extrahierten Daten

Exportieren der Daten in eine CSV-Datei

Sie können sich den obigen Code zu eigen machen, indem Sie Ihren API-Schlüssel und eine Liste von Schlüsselwörtern in die Variable keywords einfügen. Sie können auch dieselbe Logik verwenden, um die Top-Rankings für jedes Ziel-Keyword zu sammeln und so Ihre Forschungsbemühungen durch die Automatisierung dieser Prozesse zu skalieren.

Wenn Sie sich nicht mit der Programmierung befassen möchten, können Sie auch die DataPipeline von ScraperAPI verwenden, ein No-Code-Tool, mit dem Sie ganze Scraping-Projekte automatisieren können, ohne eine einzige Zeile Code zu schreiben. Fügen Sie einfach Ihre Liste von Schlüsselwörtern hinzu und lassen Sie das Tool den Rest erledigen.

Das Sammeln und Verwenden von PAA-Fragen zur Verbesserung des Inhalts Ihrer Website ist eine Geheimwaffe, die von den meisten SEO-Experten ignoriert wird. Daten sind Ihr bester Freund, wenn Sie sie zu nutzen wissen. Werden Sie also kreativ und gehen Sie an die Grenzen, um Ihre Nische zu dominieren!

Brauchen Sie eine Möglichkeit, Ihre SEO-Bemühungen zu verfolgen? Starten Sie die kostenlose Testversion von Accuranker und verschaffen Sie sich mit ein paar Klicks einen umfassenden Überblick über Ihre SEO-Kampagne.

Artikel von:

Leonardo

Leitende technische Redakteurin bei ScraperAPI

Leo ist ein technischer Autor mit Sitz in Italien und Erfahrung in Python und Node.js. Er arbeitet derzeit bei ScraperAPI als leitender technischer Autor und Content Manager...