Comment collecter plus de 100 questions liées à vos mots-clés cibles ?

Dernière mise à jour le samedi 11 novembre 2023

Alors, comment votre site web peut-il se tailler une place dans les vastes résultats fournis par le web ? Les réponses se trouvent peut-être dans les questions !

Dans l'article d'aujourd'hui, nous allons construire un scraper "People Also Ask" pour collecter des centaines (voire des milliers) de questions liées à vos mots-clés cibles, ce qui vous permettra de construire un groupe de sujets plus complet, d'optimiser votre contenu et d'améliorer l'intention de recherche.

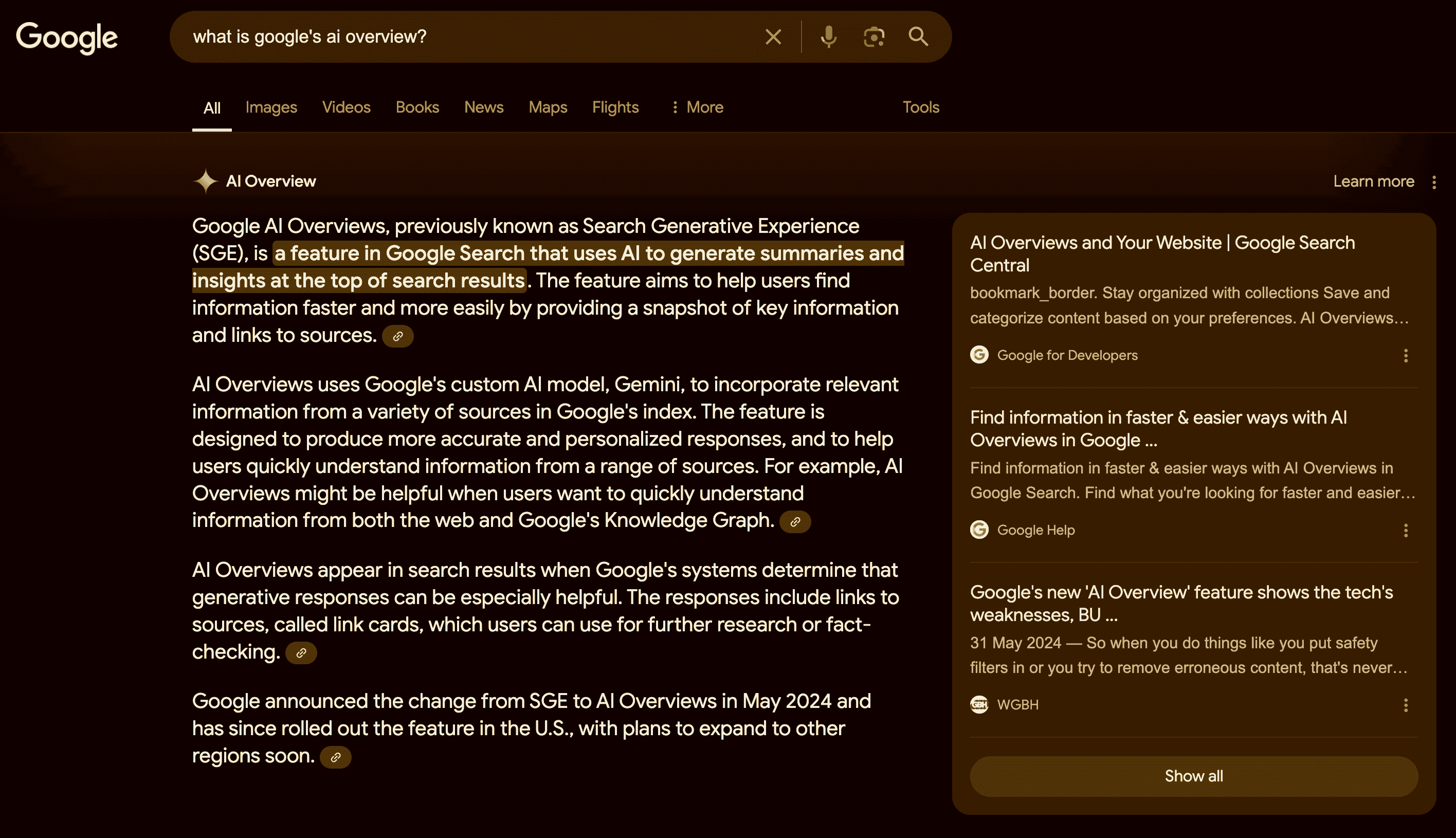

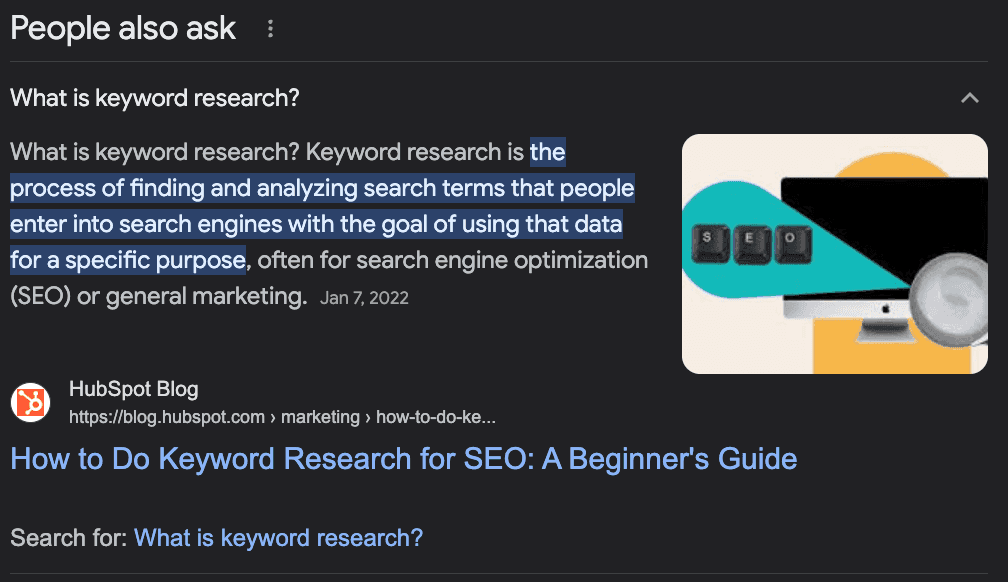

Qu'est-ce que "Les gens demandent aussi" ?

La fonctionnalité "Les gens demandent aussi" de Google est une section des résultats de recherche qui affiche des questions et des réponses connexes provenant d'autres sources. Elle aide les utilisateurs à trouver davantage d'informations sur leur requête ou à explorer différents aspects du sujet.

Cette fonction est dynamique et peut s'étendre ou se modifier en fonction de l'interaction de l'utilisateur.

Comment utiliser les questions d'AAP pour stimuler votre référencement

Bien que la fonction "People Also Ask" (PAA) soit principalement destinée aux utilisateurs finaux, elle peut s'avérer très utile pour la création et l'optimisation du contenu de votre site.

L'idée derrière l'AAP est d'aider les utilisateurs à trouver des informations supplémentaires sur leur requête ou d'aider les utilisateurs perdus qui ne sont pas sûrs de la manière dont ils recherchent un élément d'information, de sorte que Google doit "prédire" l'intention qui se cache derrière la recherche.

Vous voyez ce que je veux dire ?

Les questions de l'AAP sont un excellent moyen d'identifier les questions auxquelles votre contenu devrait répondre - ce qui accroît l'autorité du sujet - ou de nouveaux sujets pour créer du contenu autour de votre mot-clé principal.

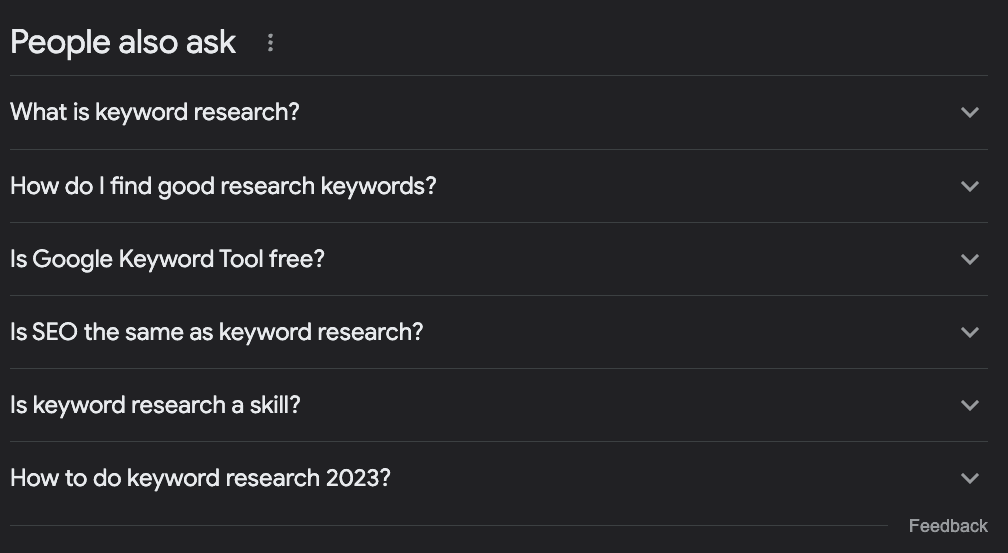

Par exemple, imaginons que vous souhaitiez rédiger un article sur la recherche de mots clés. De quoi devriez-vous parler ?

La plupart des gens recherchent le terme cible dans Google, regardent ce qui est déjà classé et s'en tiennent là.

Toutefois, si nous cochons la case AAP, nous trouverons quelques idées intéressantes :

Qu'est-ce que la recherche de mots clés ?

Comment trouver de bons mots-clés de recherche ?

L'outil Google Keyword Tool est-il gratuit ?

Le référencement est-il la même chose que la recherche de mots-clés ?

Comment faire une recherche de mots-clés en 2023 ?

Ces questions suffisent à elles seules à déterminer un certain nombre de choses :

La question "Le référencement est-il la même chose que la recherche de mots-clés ?" nous indique qu'il s'agit d'un sujet d'entrée de gamme ; les personnes qui recherchent ce terme sont donc des débutants, et nous devons leur donner le ton.

Il s'agit d'un sujet évolutif qui doit être mis à jour fréquemment, car nous avons une question sur l'année en cours.

Nous devrions ajouter une section intitulée "Qu'est-ce que la recherche de mots clés ?" et "Comment trouver de bons mots clés de recherche" - je n'utiliserais pas le second exactement comme cela, mais vous voyez ce que je veux dire.

Nous devrions mentionner comment utiliser le "planificateur de mots clés de Google" dans le cadre du tutoriel, car Google l'associe à la requête.

Nous pouvons obtenir de nombreuses informations précieuses sur nos mots-clés, dresser une liste de mots-clés apparentés, optimiser notre contenu pour répondre aux questions courantes autour du mot-clé cible et trouver de nouvelles idées de sujets pour constituer des groupes de sujets complets.

Collecte de questions "Les gens posent aussi des questions" avec Python

Mais il y a un défi à relever. La collecte de toutes ces questions pour notre contenu existant ou pour nous aider à planifier notre contenu est une tâche qui demande beaucoup de temps et de ressources.

Les référenceurs et les gestionnaires de contenu ont déjà beaucoup de travail pour ajouter des recherches supplémentaires, alors comment résoudre ce problème ?

C'est simple, nous automatisons le processus !

Nous construisons un scraper web qui :

Prendre une liste de mots-clés

Naviguer jusqu'à la page d'accueil du mot-clé

Extraire toutes les questions relatives à l'AAP

Exporter les informations dans un fichier CSV

Pour ce tutoriel, nous utiliserons Python avec un outil simple pour prendre en charge toute la complexité, et vous serez en mesure d'utiliser le code résultant en changeant simplement les mots-clés.

Vous êtes prêt ? Commençons.

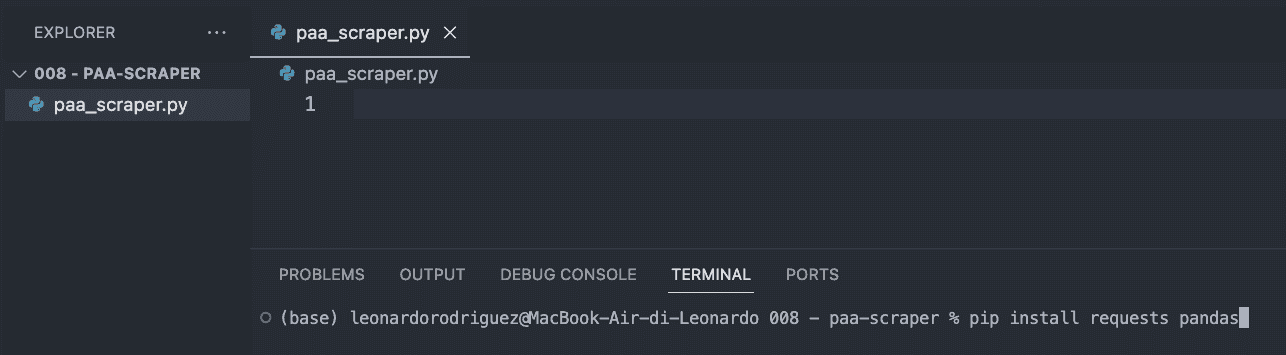

Étape 1 : Mise en place du projet

La première chose à faire est de créer un nouveau dossier pour votre projet (nommez-le paa-scraper) et de créer un nouveau fichier paa_scraper.py à l'intérieur.

Si vous êtes sur Mac, une version de Python est déjà installée sur votre machine. Si vous êtes sous Windows, suivez ce tutoriel pour l'installer sur votre machine.

Ensuite, ouvrez le dossier dans VScode et un nouveau terminal.

De là, entrez la commande suivante.

pip install requests pandasLa commande ci-dessus va installer deux outils utiles (dépendances) :

Requests nous permettra de demander les informations que nous voulons extraire

Pandas nous aidera à exporter les informations sous forme de fichier CSV.

Pour terminer cette étape, importez les deux dépendances en haut du fichier.

import requests import pandas as pdÉtape 2 : Envoi de notre requête via ScraperAPI

Traditionnellement, pour obtenir les données que nous recherchons, nous devrions construire un scraper qui navigue sur Google, recherche les informations à l'aide de sélecteurs CSS, sélectionne les informations, les formate... vous voyez ce que je veux dire ? C'est généralement beaucoup de logique.

Au lieu de cela, nous pouvons utiliser un outil de web scraping pour réduire les coûts, le temps de mise en œuvre et la maintenance.

En envoyant notre requête via les points de terminaison de données structurées de ScraperAPI, nous serons en mesure de récupérer les questions AAP de n'importe quelle requête sans nous soucier de l'analyse du code HTML, du blocage ou de tout autre problème auquel nous pourrions être confrontés.

Pour commencer, créez un compte ScraperAPI gratuit et allez sur votre tableau de bord pour copier votre clé API.

Ensuite, nous allons créer un payload comme ceci :

payload = { 'api_key' : 'YOUR_API_KEY', 'country' : 'us', 'query' : 'keyword+research', }Le paramètre "country" indique à ScraperAPI d'où envoyer vos requêtes - n'oubliez pas que Google affiche des résultats différents en fonction de votre localisation - tandis que le paramètre "query" contient votre mot-clé.

Ces paramètres étant prêts, nous pouvons envoyer notre requête à l'aide de la méthode get() :

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Étape 3 : Impression des questions de l'AAP

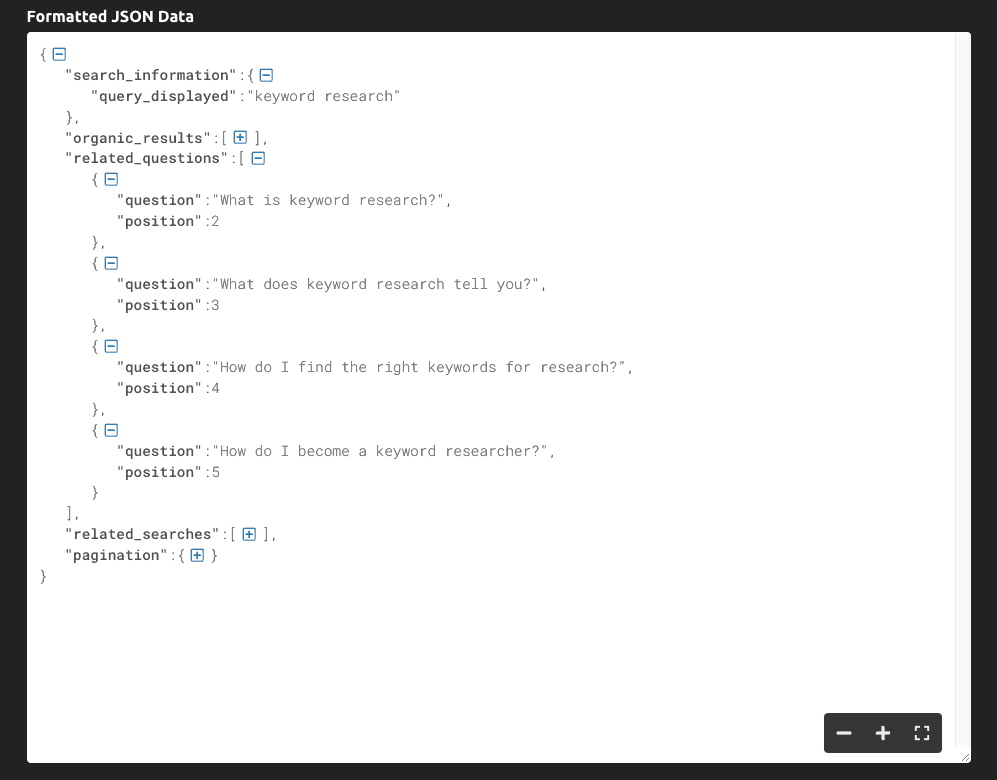

Si nous imprimons(response.text), voici les informations que nous obtenons :

Comme vous pouvez le voir, l'outil renvoie l'intégralité de la SERP sous forme de données JSON, et les principales questions liées à la requête se trouvent dans la clé "related_questions".

Comme nous obtenons des données structurées plutôt que des données HTML brutes, nous pouvons sélectionner des éléments spécifiques à l'aide de leur nom de clé :

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions : print(paa['question'])Nous stockons l'intégralité de la réponse JSON dans une variable serp

Nous récupérons les "related_questions" et créons une liste d'éléments - où chaque élément est une question de l'AAP.

Pour récupérer les questions, nous parcourons la liste en boucle et n'imprimons que la clé "question".

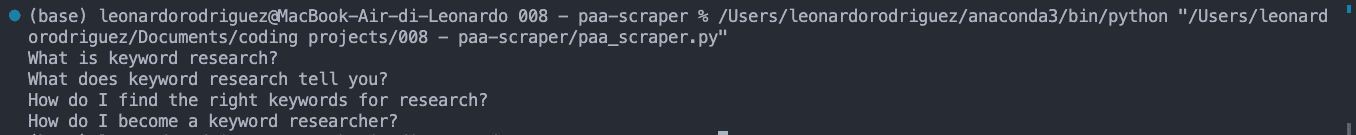

Le résultat est une liste de questions AAP imprimée sur la console :

Étape 4 : Exportation des données vers un fichier CSV

Pour le fichier CSV, nous pourrions également vouloir faire correspondre le mot-clé avec la question AAP, alors saisissons-le :

keyword = serp['search_information']['query_displayed']Une fois cette opération effectuée, nous créons une liste vide que nous utiliserons pour formater les données comme nous le souhaitons :

paa_questions = []Et y ajouter les informations extraites :

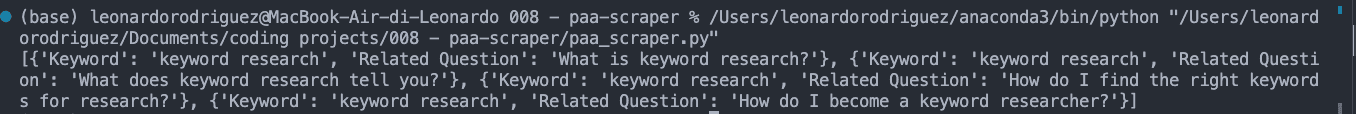

for paa in all_questions : paa_questions.append({ 'Keyword' : keyword, 'Related Question' : paa['question'] })Si nous imprimons paa_questions, voici ce que cela donne dans la console :

C'est important car c'est la base du fichier CSV et cela nous aidera à identifier d'où vient la question lorsque nous étendrons le scraper à des milliers de mots-clés.

Pour la dernière étape, créons le fichier CSV en utilisant Pandas pour faciliter l'exportation :

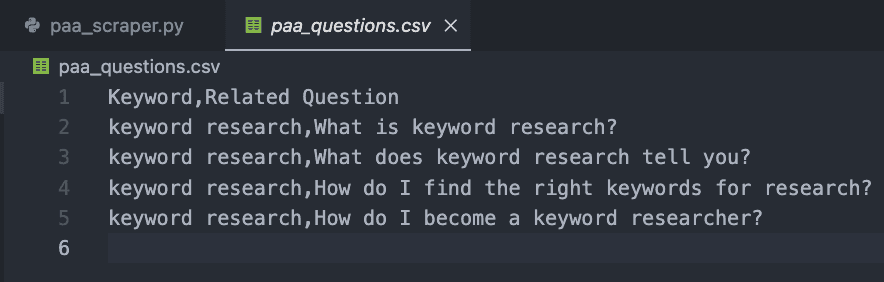

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Si vous exécutez votre code maintenant, il n'imprimera rien sur la console. Au lieu de cela, il créera un nouveau fichier CSV comme celui-ci :

Étape 5 : Collecte des questions de l'AAP à grande échelle

Bien sûr, obtenir les questions pour un seul mot-clé peut être fait à la main, alors comment faire évoluer ce projet ?

C'est là toute la beauté du web scraping. C'est une question de boucle !

Tout d'abord, créez une liste avec les mots-clés que vous souhaitez :

keywords = { 'keyword+research', 'keyword+tracker' }Ensuite, nous placerons tout notre code précédent à l'intérieur d'une nouvelle boucle, qui prendra chaque terme de la liste de mots-clés et exécutera l'ensemble du processus.

Voici l'extrait de code final et complet :

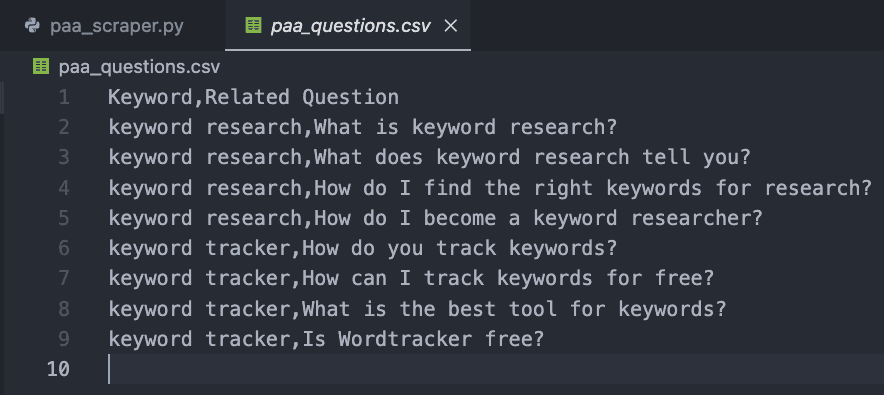

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords : payload = { 'api_key' : 'YOUR_API_KEY', 'country' : 'us', 'query' : query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions : paa_questions.append({ 'Keyword' : keyword, 'Related Question' : paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)À des fins de test, nous n'en avons ajouté que deux, mais vous pouvez créer une liste de milliers, voire de millions de mots-clés ciblés.

Le résultat est un fichier CSV facile à lire :

Félicitations, vous venez de collecter vos 9 premières questions d'AAP ! 🎉

Récapitulation

Dans cet article, vous avez appris à :

Démarrer un nouveau scraper Python

Envoyer des requêtes HTTP via ScraperAPI

Sélectionner des points de données spécifiques

Formater les données extraites

Exporter les données vers un fichier CSV

Vous pouvez vous approprier le code ci-dessus en ajoutant votre clé API et votre liste de mots-clés dans la variable keywords. Vous pouvez également utiliser la même logique pour collecter les classements les plus élevés pour chaque mot-clé ciblé, en augmentant vos efforts de recherche par l'automatisation de ces processus.

Si vous ne souhaitez pas vous occuper du codage, vous pouvez également utiliser DataPipeline de ScraperAPI, un outil sans code conçu pour automatiser des projets de scraping entiers sans écrire une seule ligne de code. Il vous suffit d'ajouter votre liste de mots-clés et de laisser l'outil faire le reste.

Recueillir et utiliser les questions de l'AAP pour améliorer le contenu de votre site est une arme secrète que la plupart des professionnels du référencement ignorent. Les données sont votre meilleur ami si vous savez les utiliser, alors soyez créatifs et repoussez les limites pour dominer votre niche !

Vous avez besoin d'un moyen de suivre vos efforts de référencement ? Commencez votre essai gratuit d'Accuranker et obtenez une image complète de votre campagne de référencement en quelques clics.

Article par:

Leonardo

Rédacteur technique principal chez ScraperAPI

Leo est un rédacteur de contenu technique basé en Italie avec de l'expérience en Python et Node.js. Il travaille actuellement pour ScraperAPI en tant que rédacteur technique principal et gestionnaire de contenu...