Jak zebrać ponad 100 pytań powiązanych z docelowymi słowami kluczowymi?

Ostatnia aktualizacja sobota, 11 listopada 2023

Jak więc Twoja witryna może wyrzeźbić miejsce w ogromnych wynikach, jakie zapewnia sieć? Cóż, odpowiedzi mogą leżeć w pytaniach!

W dzisiejszym artykule zbudujemy skrobak "Ludzie też pytają", aby zebrać setki (a nawet tysiące) powiązanych pytań wokół docelowych słów kluczowych, umożliwiając zbudowanie bardziej wszechstronnego klastra tematycznego, optymalizację treści i poprawę intencji wyszukiwania.

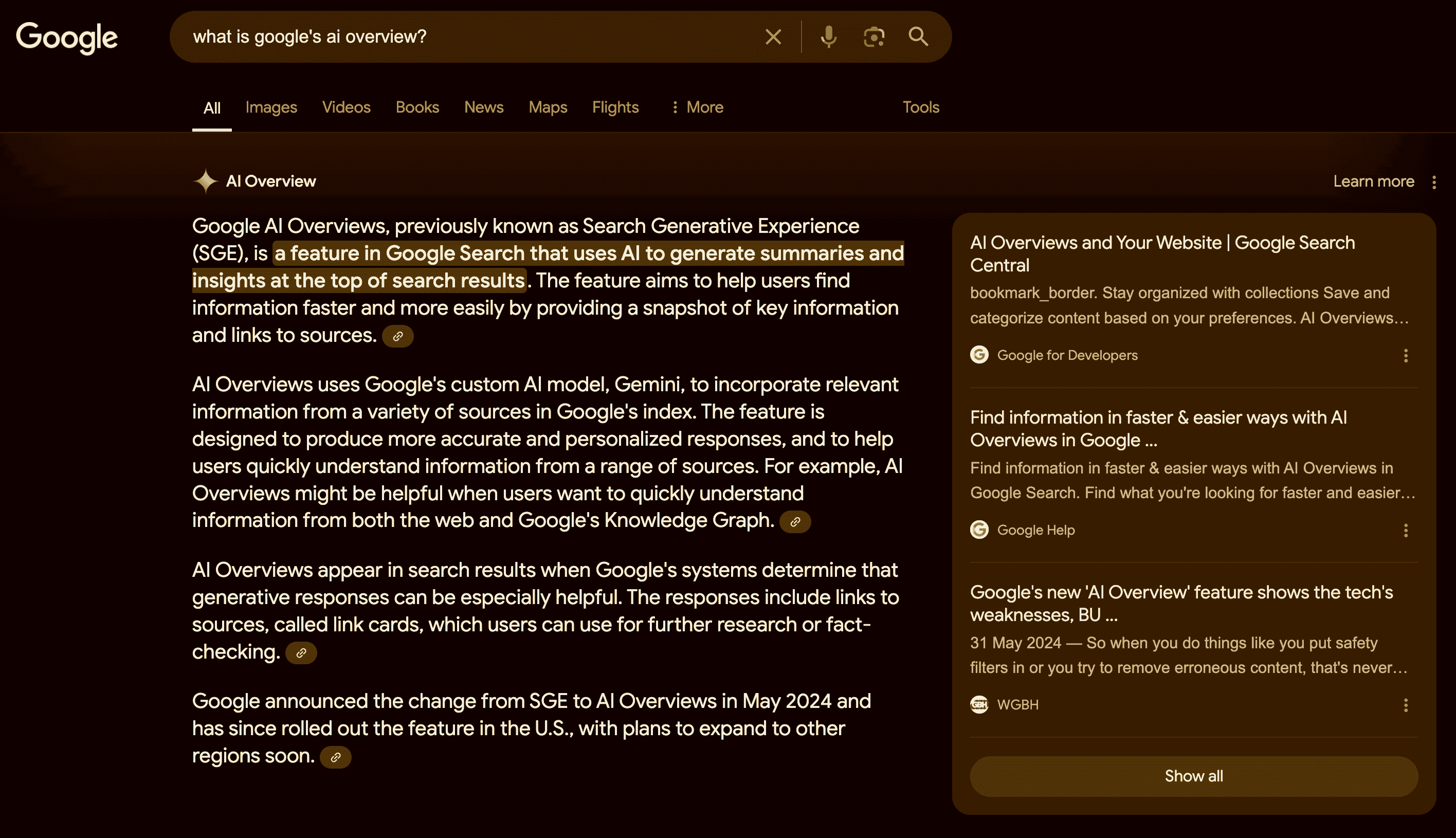

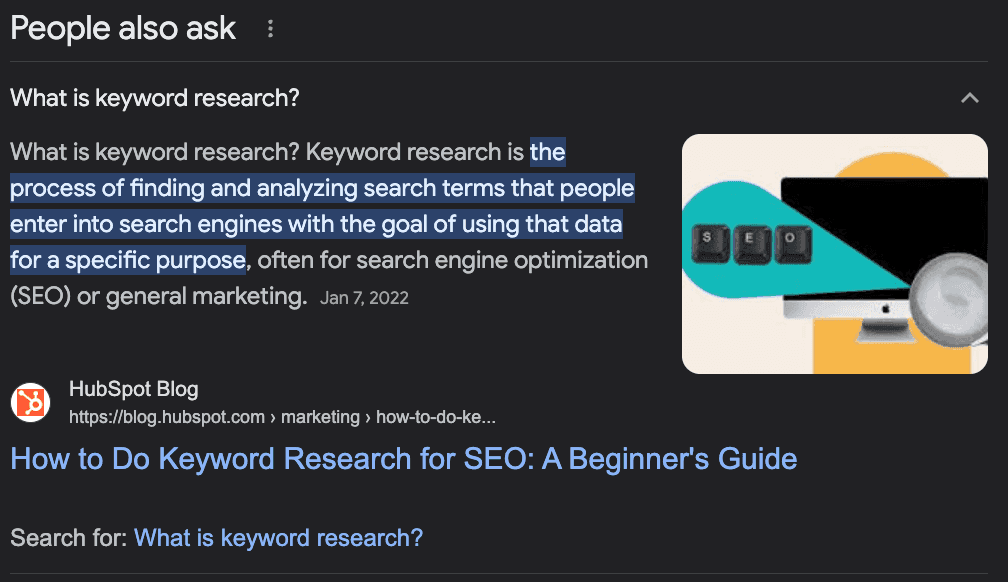

Co to jest "Ludzie też pytają"?

Funkcja Google "Ludzie też pytają" to sekcja wyników wyszukiwania, która pokazuje powiązane pytania i odpowiedzi z innych źródeł. Pomaga użytkownikom znaleźć więcej informacji na temat ich zapytania lub zbadać różne aspekty tematu.

Funkcja ta jest dynamiczna i może się rozszerzać lub zmieniać w zależności od interakcji użytkownika.

Jak korzystać z pytań PAA, aby zwiększyć swoje SEO?

Chociaż "People Also Ask" (PAA) jest głównie funkcją dla użytkowników końcowych, może być świetnym sprzymierzeńcem w tworzeniu i optymalizacji treści witryny.

Ideą PAA jest pomoc użytkownikom w znalezieniu dodatkowych informacji na temat ich zapytania lub pomoc zagubionym użytkownikom, którzy nie są pewni, jak szukać informacji, więc Google musi "przewidzieć" intencje stojące za wyszukiwaniem.

Rozumiesz już o co chodzi?

Pytania PAA to świetny sposób na zidentyfikowanie potencjalnych pytań, na które powinna odpowiadać treść - zwiększając autorytet tematu - lub nowych tematów do tworzenia treści wokół głównego słowa kluczowego.

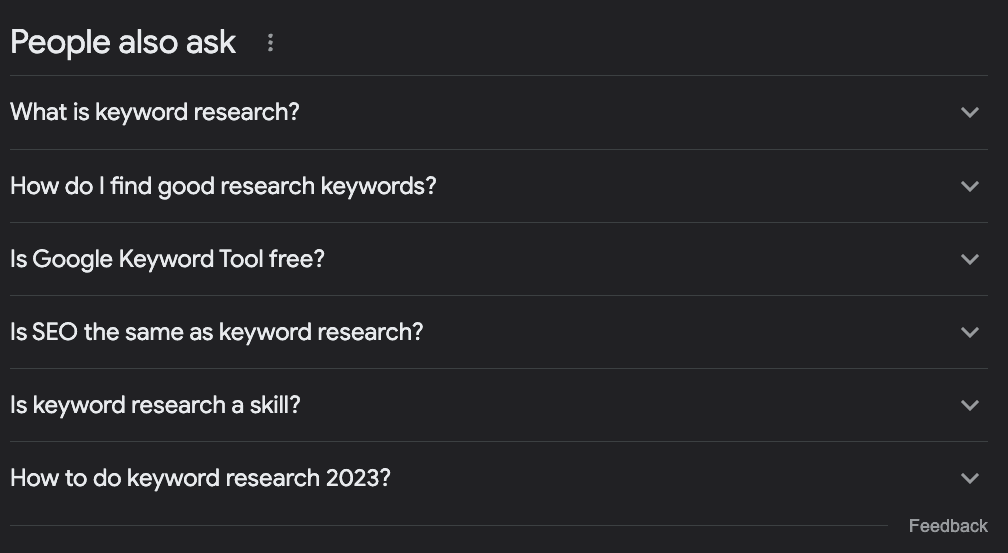

Załóżmy na przykład, że chcesz napisać artykuł na temat badania słów kluczowych. Co powinno się w nim znaleźć?

Większość ludzi wyszuka docelowy termin w Google, spojrzy na to, co już jest w rankingu i nazwie to dniem.

Jeśli jednak sprawdzimy pole PAA, znajdziemy kilka interesujących pomysłów:

Czym jest badanie słów kluczowych?

Jak znaleźć dobre słowa kluczowe do badań?

Czy Narzędzie Google Keyword jest darmowe?

Czy SEO to to samo, co badanie słów kluczowych?

Jak przeprowadzić badanie słów kluczowych 2023?

Tylko na podstawie tych pytań możemy ustalić kilka rzeczy:

Pytanie "Czy SEO to to samo, co badanie słów kluczowych?" mówi nam, że jest to temat bardzo podstawowy, więc osoby wyszukujące ten termin są początkującymi i powinniśmy nadać im ton.

Jest to rozwijający się temat, który należy często aktualizować, ponieważ mamy pytanie dotyczące bieżącego roku.

Powinniśmy dodać sekcję z nagłówkami "Co to jest badanie słów kluczowych?" i "Jak znaleźć dobre słowa kluczowe do wyszukiwania" - nie użyłbym drugiego dokładnie w ten sposób, ale masz sens.

Powinniśmy wspomnieć o tym, jak korzystać z "Google Keyword Planner" w ramach samouczka, ponieważ Google wiąże go z zapytaniem.

Możemy uzyskać wiele cennych informacji na temat naszych słów kluczowych, zbudować listę powiązanych słów kluczowych, zoptymalizować nasze treści, aby odpowiedzieć na typowe pytania dotyczące docelowego słowa kluczowego, a także znaleźć nowe pomysły tematyczne, aby zbudować kompletne klastry tematyczne.

Zbieranie pytań "Ludzie też pytają" za pomocą Pythona

Jest jednak pewne wyzwanie. Zbieranie wszystkich tych pytań do naszych istniejących treści lub do wykorzystania jako wsparcie przy planowaniu naszych treści jest zadaniem czasochłonnym i wymagającym dużej ilości zasobów.

SEO i menedżerowie treści mają już dużo pracy, aby dodać dodatkowe badania, więc jak to rozwiązać?

To proste, zautomatyzujemy ten proces!

Zbudujemy skrobak internetowy, który:

pobierze listę słów kluczowych

Przejść do SERP słowa kluczowego

Wyodrębni wszystkie pytania PAA

Eksportować informacje do pliku CSV

W tym samouczku użyjemy Pythona z prostym narzędziem, które zajmie się całą złożonością, a wynikowy kod będzie można wykorzystać, zmieniając tylko słowa kluczowe.

Gotowy? Zaczynajmy.

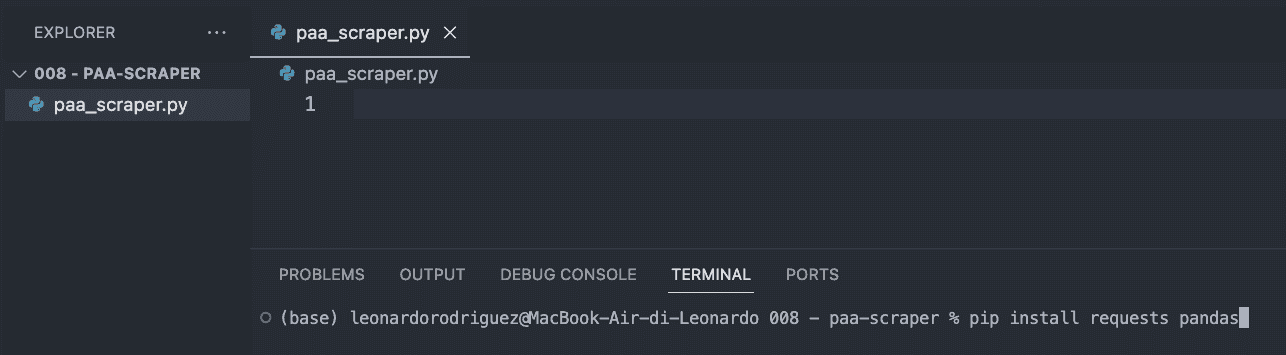

Krok 1: Konfiguracja projektu

Pierwszą rzeczą do zrobienia jest utworzenie nowego folderu dla projektu (nazwij go paa-scraper) i utworzenie w nim nowego pliku paa_scraper.py.

Jeśli korzystasz z komputera Mac, Twoja maszyna ma już zainstalowaną wersję Pythona. Jeśli korzystasz z systemu Windows, postępuj zgodnie z tym samouczkiem, aby zainstalować go na swoim komputerze.

Następnie otwórz folder w VScode i nowy terminal.

Następnie wprowadź następujące polecenie.

pip install requests pandasPowyższe polecenie zainstaluje dwa przydatne narzędzia (zależności):

Requests pozwoli nam poprosić o informacje, które chcemy wyodrębnić

Pandas pomoże nam wyeksportować informacje jako plik CSV

Aby zakończyć ten krok, zaimportuj obie zależności na początku pliku.

import requests import pandas as pdKrok 2: Wysyłanie naszego żądania przez ScraperAPI

Tradycyjnie, aby uzyskać dane, których szukamy, musielibyśmy zbudować scraper, który nawiguje do Google, wyszukuje informacje za pomocą selektorów CSS, wybiera informacje, formatuje je... wiesz, co mam na myśli? Zwykle jest to dużo logiki.

Zamiast tego możemy użyć narzędzia do skrobania stron internetowych, aby zmniejszyć koszty, czas wdrożenia i konserwacji.

Wysyłając nasze żądanie za pośrednictwem punktów końcowych danych strukturalnych ScraperAPI, będziemy mogli pobrać pytania PAA z dowolnego zapytania, nie martwiąc się o analizowanie kodu HTML, blokowanie lub inne problemy, z którymi możemy się spotkać.

Aby rozpocząć, utwórz bezpłatne konto ScraperAPI i przejdź do pulpitu nawigacyjnego, aby skopiować klucz API.

Następnie utworzymy ładunek w następujący sposób:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }Parametr kraju powie ScraperAPI, skąd wysyłać żądania - pamiętaj, że Google pokazuje różne wyniki w zależności od Twojej lokalizacji - podczas gdy parametr zapytania zawiera słowo kluczowe.

Mając gotowe parametry, możemy wysłać nasze żądanie za pomocą metody get():

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Krok 3: Drukowanie pytań PAA

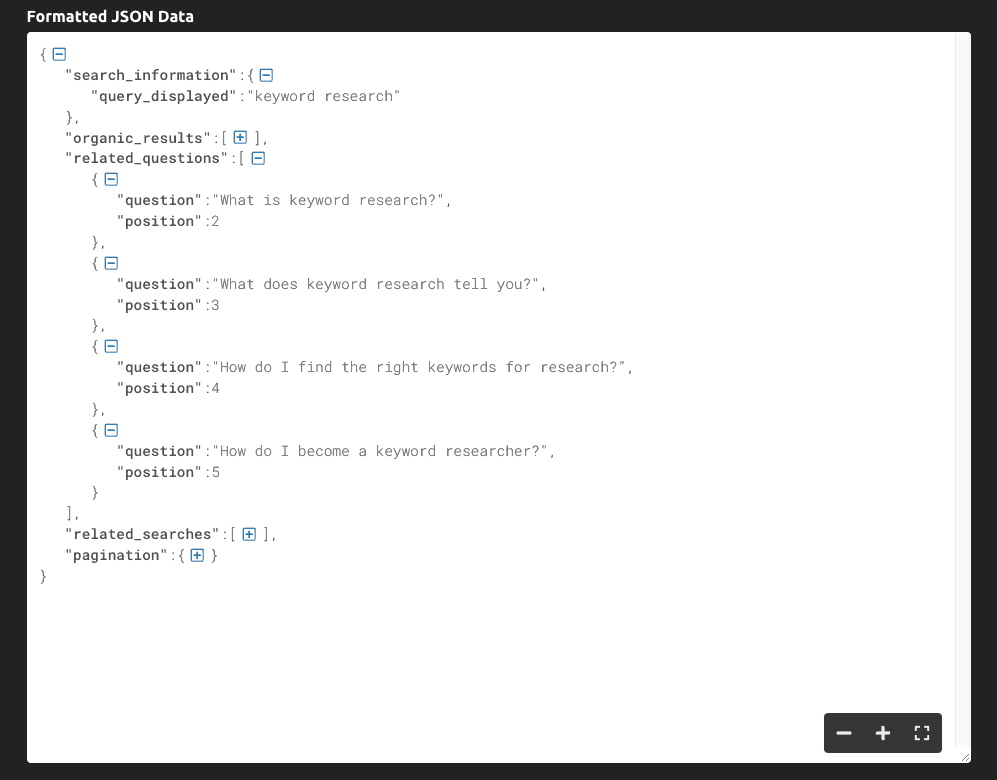

Jeśli wydrukujemy (response.text), otrzymamy następujące informacje:

Jak widać, narzędzie zwraca cały SERP jako dane JSON, a główne pytania związane z zapytaniem znajdują się w kluczu "related_questions".

Ponieważ otrzymujemy ustrukturyzowane dane zamiast surowych danych HTML, możemy wybrać określone elementy za pomocą ich nazwy klucza:

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])Przechowujemy całą odpowiedź JSON w zmiennej serp

Pobieramy "related_questions" i tworzymy listę elementów - gdzie każdy element jest pytaniem PAA.

Aby pobrać pytania, zapętlamy listę i drukujemy tylko klucz "question".

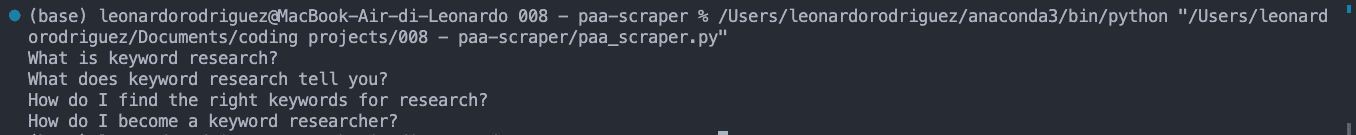

Wynikiem tego jest lista pytań PAA wydrukowana na konsoli:

Krok 4: Eksportowanie danych do pliku CSV

W przypadku pliku CSV możemy również chcieć dopasować słowo kluczowe do pytania PAA, więc pobierzmy je:

keyword = serp['search_information']['query_displayed']Po wykonaniu tej czynności utworzymy pustą listę, której użyjemy do sformatowania danych zgodnie z naszymi potrzebami:

paa_questions = []I dołączymy do niej wyodrębnione informacje:

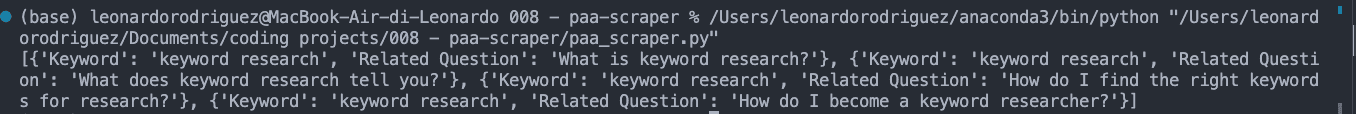

for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] })Jeśli wydrukujemy paa_questions, oto jak to wygląda w konsoli:

Jest to ważne, ponieważ jest to podstawa pliku CSV i pomoże nam zidentyfikować, skąd pochodzi pytanie, gdy rozszerzymy scraper na tysiące słów kluczowych.

W ostatnim kroku utwórzmy plik CSV za pomocą Pandas w celu łatwego eksportu:

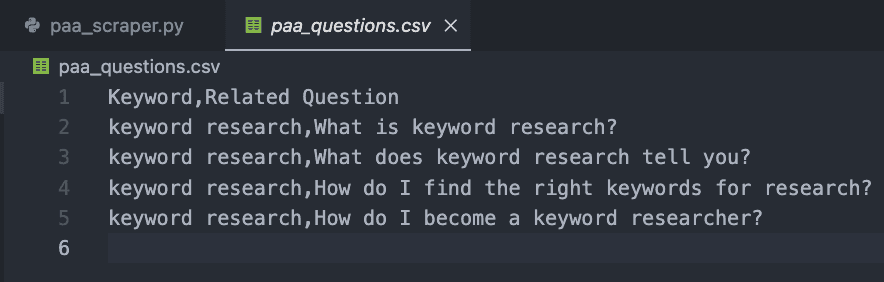

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Jeśli teraz uruchomisz swój kod, nie wydrukuje on niczego w konsoli. Zamiast tego utworzy nowy plik CSV, taki jak ten:

Krok 5: Zbieranie pytań PAA na dużą skalę

Oczywiście, uzyskanie pytań tylko dla jednego słowa kluczowego może być wykonane ręcznie, więc jak możemy skalować ten projekt?

Cóż, oto piękno web scrapingu. Wszystko sprowadza się do pętli!

Najpierw utwórz listę z pożądanymi słowami kluczowymi:

keywords = { 'keyword+research', 'keyword+tracker' }Następnie umieścimy cały nasz poprzedni kod wewnątrz nowej pętli, która pobierze każdy termin z listy słów kluczowych i uruchomi cały proces.

Oto ostateczny i pełny fragment kodu:

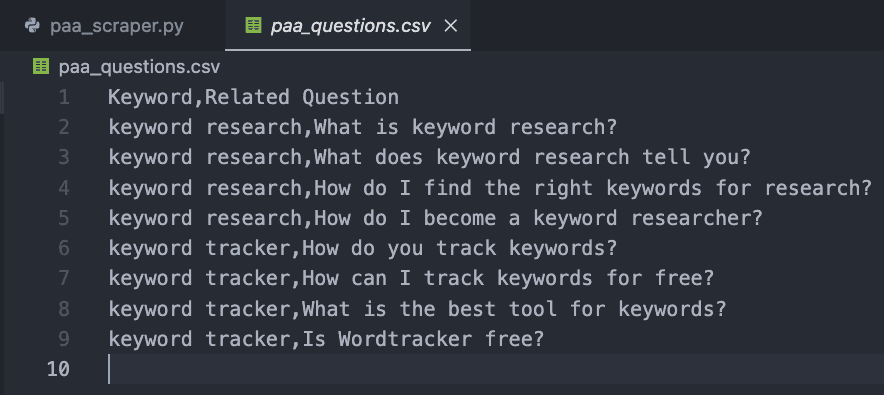

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({ 'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Do celów testowych dodaliśmy tylko dwa, ale można utworzyć listę tysięcy, a nawet milionów docelowych słów kluczowych.

Rezultatem jest łatwy do odczytania plik CSV:

Gratulacje, właśnie zebrałeś swoje pierwsze 9 pytań PAA! 🎉

Podsumowanie

Z tego artykułu dowiedziałeś się, jak

Uruchomić nowy scraper Pythona

Wysyłać żądania HTTP za pośrednictwem ScraperAPI

Wybierać określone punkty danych

Formatować wyodrębnione dane

Eksportować dane do pliku CSV

Powyższy kod można dostosować do własnych potrzeb, dodając klucz API i listę słów kluczowych w zmiennej keywords. Możesz również użyć tej samej logiki do zbierania najlepszych rankingów dla każdego docelowego słowa kluczowego, skalując swoje wysiłki badawcze poprzez automatyzację tych procesów.

Jeśli nie chcesz zajmować się kodowaniem, możesz również użyć DataPipeline ScraperAPI, narzędzia bez kodu zaprojektowanego do automatyzacji całych projektów scrapingu bez pisania ani jednej linii kodu. Wystarczy dodać listę słów kluczowych i pozwolić narzędziu zająć się resztą.

Zbieranie i wykorzystywanie pytań PAA do ulepszania treści witryny to tajna broń, którą ignoruje większość specjalistów SEO. Dane są najlepszym przyjacielem, jeśli wiesz, jak z nich korzystać, więc bądź kreatywny i przekraczaj granice, aby zdominować swoją niszę!

Potrzebujesz sposobu na śledzenie swoich działań SEO? Rozpocznij bezpłatny okres próbny Accuranker i uzyskaj pełny obraz swojej kampanii SEO za pomocą kilku kliknięć.

Artykuł autorstwa:

Leonardo

Główny autor tekstów technicznych w ScraperAPI

Leo jest pisarzem treści technicznych z siedzibą we Włoszech z doświadczeniem w Pythonie i Node.js. Obecnie pracuje w ScraperAPI jako główny pisarz techniczny i menedżer treści.