Hur man samlar in 100+ relaterade frågor till dina målnyckelord

Senast uppdaterad den lördag 11 november 2023

Så hur kan din webbplats skapa en plats i de enorma resultat som webben ger? Tja, svaren kan ligga i frågorna!

I dagens artikel kommer vi att bygga en "People Also Ask"-skrapa för att samla in hundratals (eller till och med tusentals) relaterade frågor kring dina målsökord, så att du kan bygga ett mer omfattande ämneskluster, optimera ditt innehåll och förbättra sökintentionen.

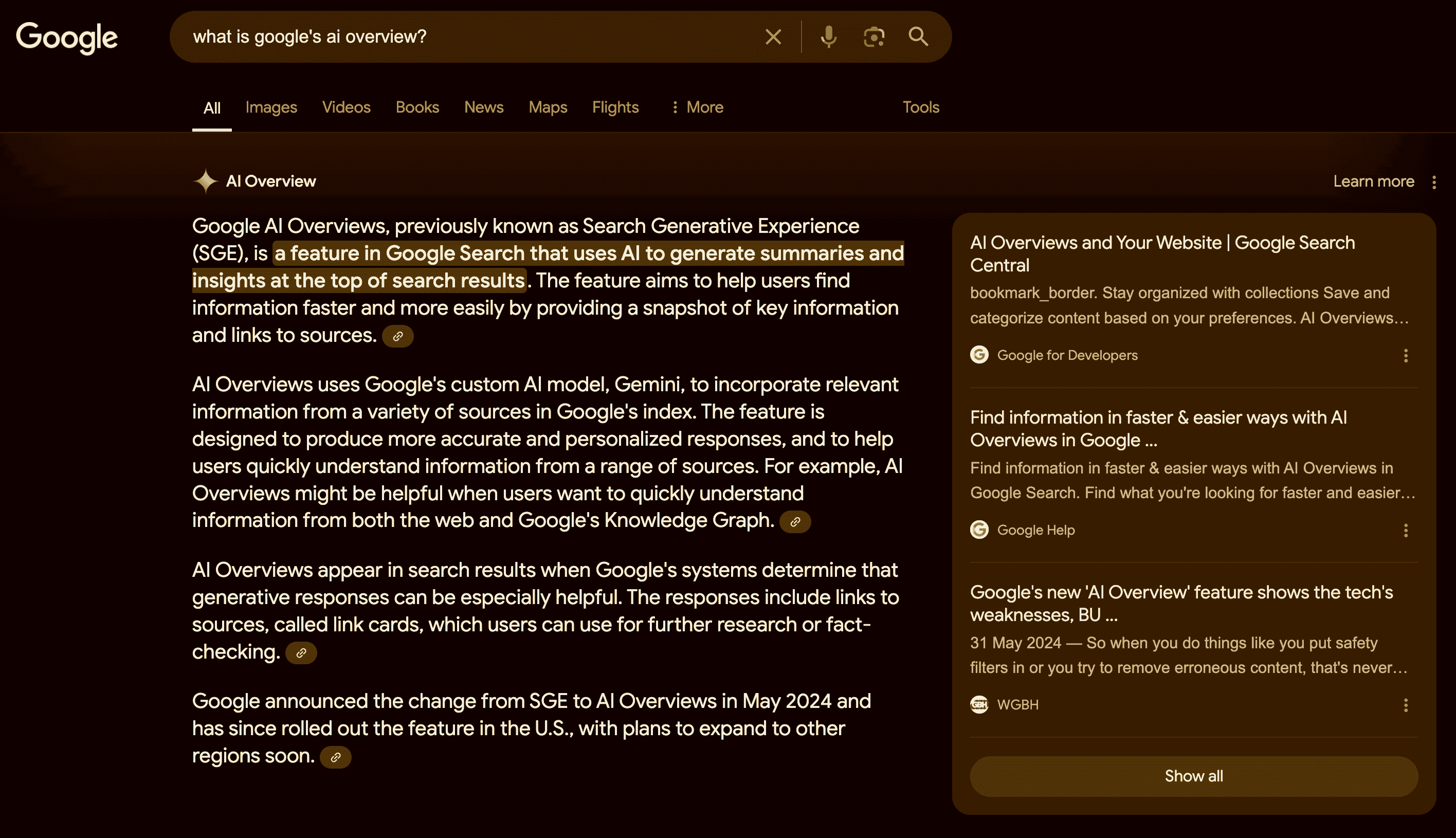

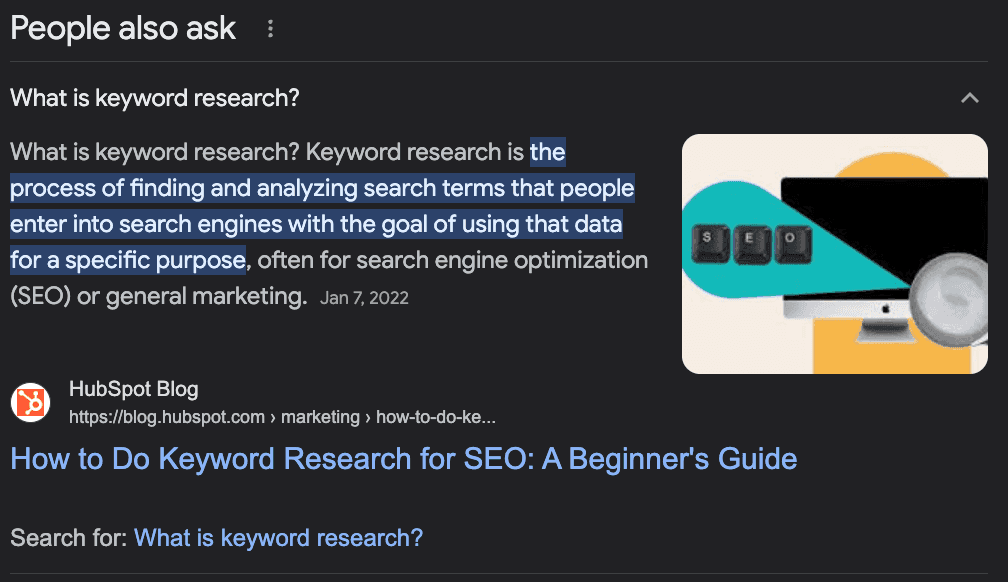

Vad är "Människor frågar också"?

Googles "People Also Ask"-funktion är en del av sökresultaten som visar relaterade frågor och svar från andra källor. Det hjälper användarna att hitta mer information om sin fråga eller utforska olika aspekter av ämnet.

Funktionen är dynamisk och kan expandera eller förändras beroende på användarens interaktion.

Hur du använder PAA-frågor för att öka din SEO

Även om "People Also Ask" (PAA) främst är en slutanvändarfunktion kan den vara en bra allierad när det gäller att skapa och optimera innehållet på din webbplats.

Tanken bakom PAA är att hjälpa användare att hitta ytterligare information om sin fråga eller hjälpa vilsna användare som inte är säkra på hur de ska söka efter en viss information, så Google måste "förutsäga" avsikten bakom sökningen.

Förstår du nu vad jag menar?

PAA-frågor är ett utmärkt sätt att identifiera potentiella frågor som ditt innehåll bör besvara - vilket ökar ämnets auktoritet - eller nya ämnen för att skapa innehåll kring ditt huvudnyckelord.

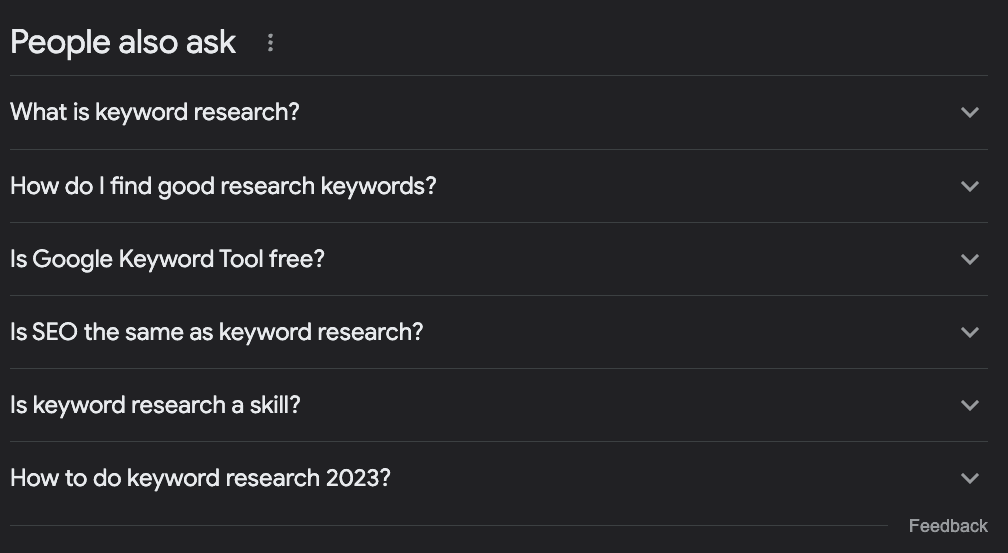

Låt oss till exempel säga att du vill skriva en artikel om att göra sökordsforskning. Vad bör du ta upp?

De flesta människor kommer att söka efter måltermen i Google, ta en titt på vad som redan rankas och kalla det en dag.

Men om vi kollar PAA-rutan hittar vi några intressanta idéer:

Vad är sökordsforskning?

Hur hittar jag bra forskningsnyckelord?

Är Google Keyword Tool gratis?

Är SEO detsamma som sökordsforskning?

Hur gör man sökordsforskning 2023?

Bara från dessa frågor kan vi bestämma några saker:

Frågan "Är SEO samma sak som sökordsforskning?" berättar för oss att detta är ett mycket nybörjarämne, så människor som söker efter denna term är nybörjare, och vi bör sätta tonen för dem.

Det är ett ämne som utvecklas och som måste uppdateras ofta eftersom vi har en fråga om innevarande år.

Vi bör lägga till ett avsnitt med rubrikerna "Vad är sökordsforskning?" och "Hur hittar jag bra sökord" - jag skulle inte använda den andra exakt så, men du förstår poängen.

Vi bör nämna hur man använder "Google Keyword Planner" som en del av handledningen, eftersom Google knyter det till frågan.

Vi kan få mycket värdefull information om våra sökord, bygga en lista med relaterade sökord, optimera vårt innehåll för att svara på vanliga frågor kring målnyckelordet och hitta nya ämnesidéer för att bygga kompletta ämneskluster.

Samla in "Folk frågar också"-frågor med Python

Det finns dock en utmaning. Att samla in alla dessa frågor för vårt befintliga innehåll eller för att använda som stöd för att planera vårt innehåll är en tidskrävande och resurskrävande uppgift.

SEO:er och innehållsansvariga har redan mycket arbete med att lägga till extra forskning, så hur löser vi det?

Enkelt, vi automatiserar processen!

Vi ska bygga en webbskrapa som:

Ta en lista med nyckelord

Navigera till sökordets SERP

Extrahera alla PAA-frågor

Exportera informationen till en CSV

För denna handledning använder vi Python med ett enkelt verktyg för att ta hand om all komplexitet, och du kommer att kunna använda den resulterande koden genom att bara ändra nyckelorden.

Är du redo? Låt oss sätta igång.

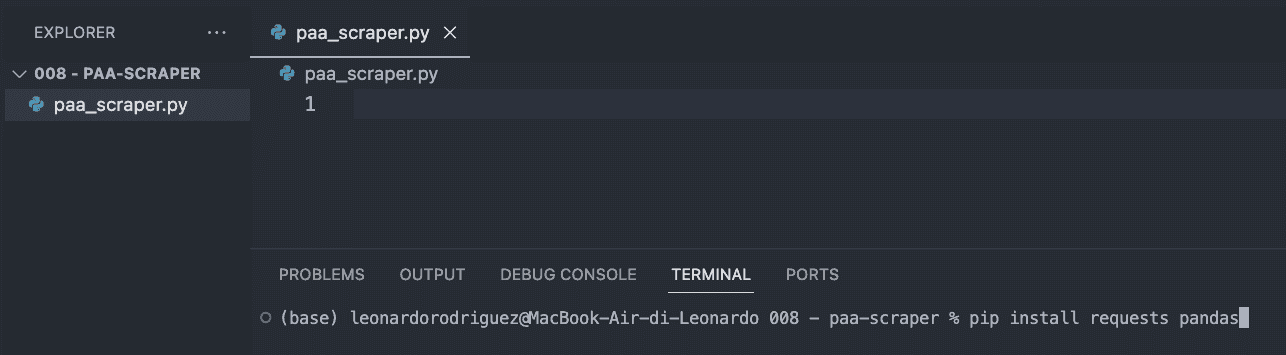

Steg 1: Konfigurera ditt projekt

Det första du ska göra är att skapa en ny mapp för ditt projekt (namnge den paa-scraper) och skapa en ny paa_scraper.py-fil inuti.

Om du är på Mac har din maskin redan en version av Python installerad. Om du är på Windows, följ den här handledningen för att få den på din maskin.

Öppna sedan mappen i VScode och en ny terminal.

Därifrån anger du följande kommando.

pip installera förfrågningar pandasKommandot ovan kommer att installera två användbara verktyg (beroenden):

Requests låter oss be om den information vi vill extrahera

Pandas hjälper oss att exportera informationen som en CSV-fil

För att avsluta det här steget importerar du båda beroendena längst upp i filen.

importera förfrågningar importera pandas som pdSteg 2: Skicka vår begäran via ScraperAPI

För att få de data vi letar efter måste vi traditionellt bygga en scraper som navigerar till Google, söker efter informationen med hjälp av CSS-selektorer, plockar informationen, formaterar den ... du vet vad jag menar? Det är vanligtvis mycket logik.

Istället kan vi använda ett webbskrapningsverktyg för att minska kostnader, implementeringstid och underhåll.

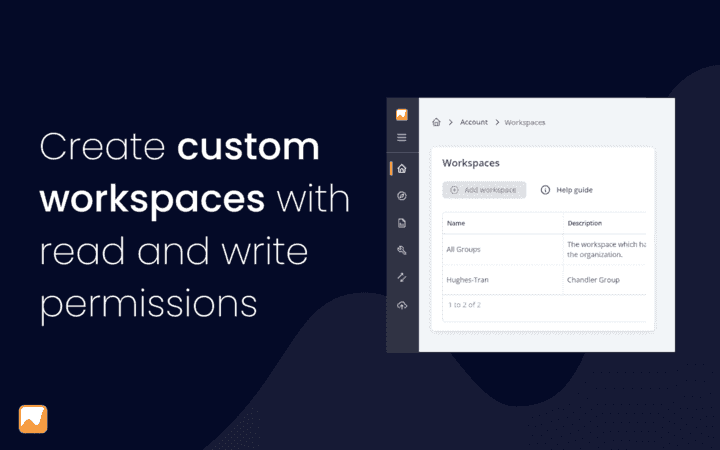

Genom att skicka vår begäran via ScraperAPI:s endpoints för strukturerad data kan vi hämta PAA-frågorna i alla frågor utan att behöva oroa oss för att analysera HTML, bli blockerade eller något annat problem vi kan stöta på.

För att komma igång skapar du ett gratis ScraperAPI-konto och går till din instrumentpanel för att kopiera din API-nyckel.

Sedan skapar vi en nyttolast så här:

payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': 'keyword+research', }Parametern country talar om varifrån ScraperAPI ska skicka dina förfrågningar - kom ihåg att Google visar olika resultat baserat på var du befinner dig - medan parametern query innehåller ditt sökord.

Med dessa parametrar klara kan vi skicka vår begäran med hjälp av get()-metoden:

response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)Steg 3: Skriva ut PAA-frågor

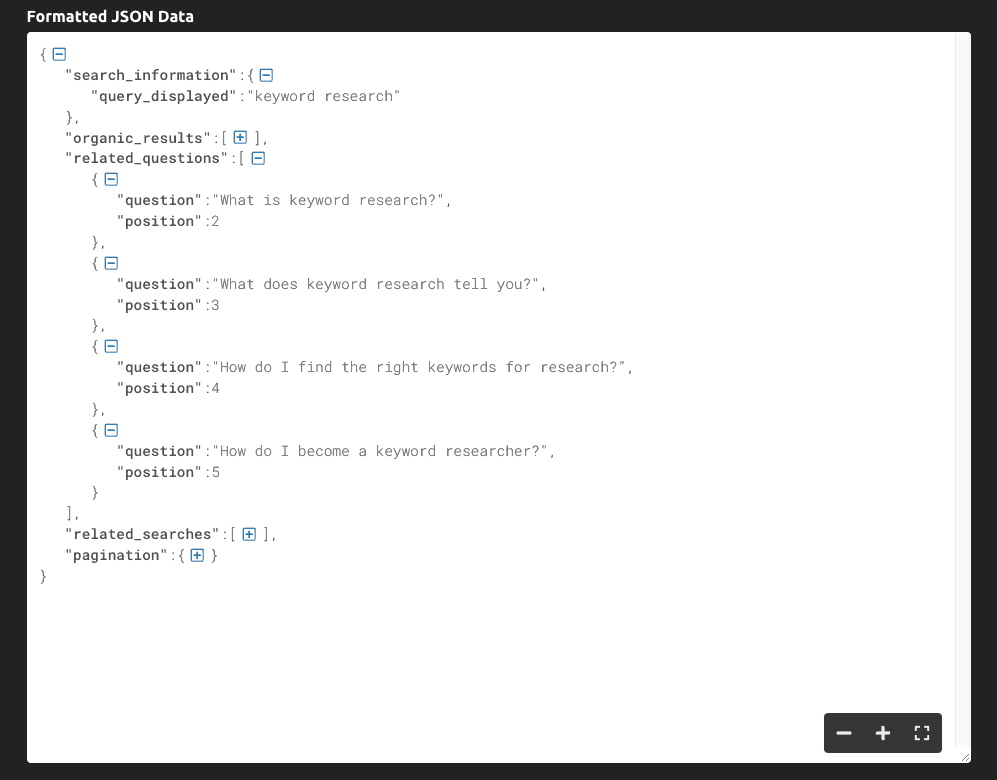

Om vi skriver ut(response.text) är detta den information vi får:

Som du kan se returnerar verktyget hela SERP som JSON-data, och de viktigaste frågorna relaterade till frågan finns i "related_questions"-nyckeln.

Eftersom vi får strukturerad data istället för rå HTML-data kan vi välja specifika element med hjälp av deras nyckelnamn:

serp = response.json() all_questions = serp['related_questions'] for paa in all_questions: print(paa['question'])Vi lagrar hela JSON-svaret i en serp-variabel

Vi hämtar "related_questions" och skapar en lista med objekt - där varje objekt är en PAA-fråga

För att få tag på frågorna loopar vi genom listan och skriver bara ut "question"-nyckeln

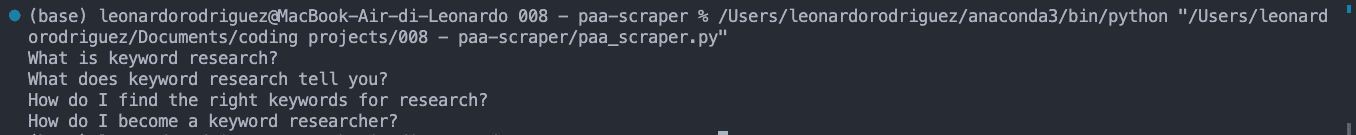

Resultatet av detta är en lista med PAA-frågor som skrivs ut på konsolen:

Steg 4: Exportera data till en CSV-fil

För CSV-filen kanske vi också vill matcha nyckelordet med PAA-frågan, så låt oss ta tag i det:

nyckelord = serp['search_information']['query_displayed']När detta är gjort skapar vi en tom lista som vi använder för att formatera data som vi vill:

paa_questions = []Och lägger till den extraherade informationen till den:

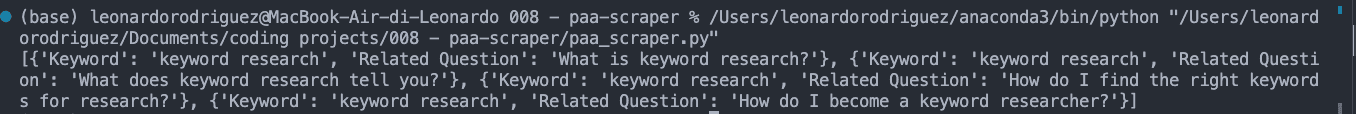

for paa in all_questions: paa_questions.append({ 'Nyckelord': nyckelord, 'Relaterad fråga': paa['fråga'] })Om vi skriver ut paa_questions ser det ut så här i konsolen:

Detta är viktigt eftersom det är basen i CSV-filen och kommer att hjälpa oss att identifiera var frågan kommer ifrån när vi utökar skrapan till tusentals nyckelord.

För det sista steget, låt oss skapa CSV-filen med Pandas för enkel export:

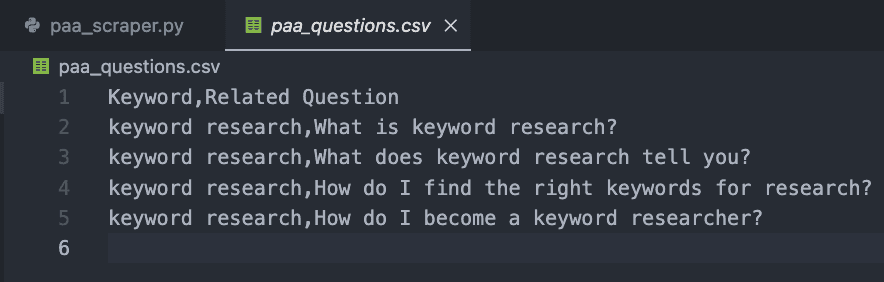

db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)Om du kör din kod nu kommer den inte att skriva ut något till konsolen. Istället skapar den en ny CSV-fil så här:

Steg 5: Samla in PAA-frågor i stor skala

Naturligtvis kan man få frågorna för bara ett nyckelord för hand, så hur skalar vi det här projektet?

Tja, här är skönheten i webbskrotning. Det handlar om slingan!

Skapa först en lista med dina önskade nyckelord:

nyckelord = { 'nyckelord+forskning', 'nyckelord+spårare' }Sedan lägger vi in all vår tidigare kod i en ny loop, som tar varje term i sökordslistan och kör hela processen.

Här är det slutliga och fullständiga kodavsnittet:

import requests import pandas as pd paa_questions = [] keywords = { 'keyword+research', 'keyword+tracker' } for query in keywords: payload = { 'api_key': 'YOUR_API_KEY', 'country': 'us', 'query': query, } response = requests.get('https://api.scraperapi.com/structured/google/search', params=payload) serp = response.json() keyword = serp['search_information']['query_displayed'] all_questions = serp['related_questions'] for paa in all_questions: paa_questions.append({'Keyword': keyword, 'Related Question': paa['question'] }) db = pd.DataFrame(paa_questions) db.to_csv('paa_questions.csv', index=False)För teständamål lade vi bara till två, men du kan skapa en lista med tusentals eller till och med miljontals riktade nyckelord.

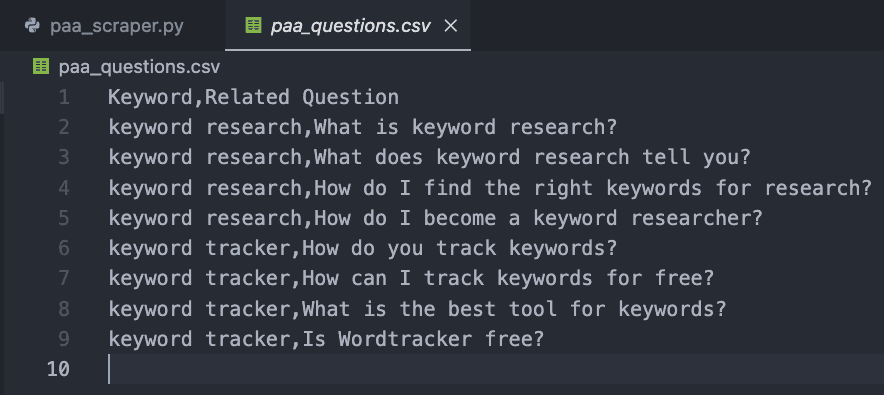

Resultatet är en lättläst CSV-fil:

Grattis, du har precis samlat in dina första 9 PAA-frågor! 🎉

Avslutning

I den här artikeln har du lärt dig hur du gör:

Starta en ny Python-skrapa

Skicka HTTP-förfrågningar via ScraperAPI

Välja specifika datapunkter

Formatera den extraherade datan

Exportera data till en CSV-fil

Du kan göra koden ovan till din egen genom att lägga till din API-nyckel och lista över nyckelord i variabeln keywords. Du kan också använda samma logik för att samla in topprankningar för varje målnyckelord och skala upp dina forskningsinsatser genom att automatisera dessa processer.

Om du inte vill hantera kodning kan du också använda ScraperAPI: s DataPipeline, ett verktyg utan kod som är utformat för att automatisera hela skrapningsprojekt utan att skriva en enda kodrad. Lägg bara till din lista med nyckelord och låt verktyget göra resten.

Att samla in och använda PAA-frågor för att förbättra innehållet på din webbplats är ett hemligt vapen som de flesta SEO-proffs ignorerar. Data är din bästa vän om du vet hur du ska använda den, så var kreativ och tänj på gränserna för att dominera din nisch!

Behöver du ett sätt att spåra dina SEO-insatser? Starta din kostnadsfria testversion av Accuranker och få en fullständig bild av din SEO-kampanj med ett par klick.

Artikel av:

Leonardo

Ledande teknisk skribent på ScraperAPI

Leo är en teknisk innehållsförfattare baserad i Italien med erfarenhet av Python och Node.js. Han arbetar för närvarande med ScraperAPI som ledande teknisk skribent och innehållsansvarig...